- 1.支持的算法

- 1.1 Box Filter

- 1.2 Bilateral Filter

- 1.3 Gaussian Filter

- 1.4 Gaussian Pyramid Generator

- 1.5 Laplacian Pyramid Generator

- 1.6 Erode

- 1.7 Dilate

- 1.8 Convolution

- 1.9 Separable Convolution

- 1.10 Convert Image Format

- 1.11 Rescale

- 1.12 Remap

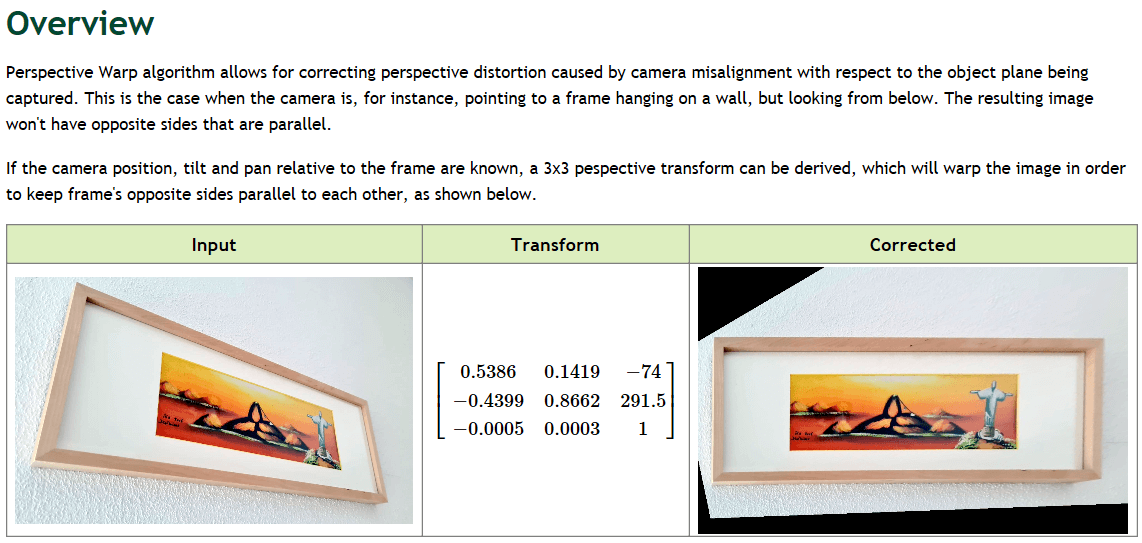

- 1.13 Perspective Warp

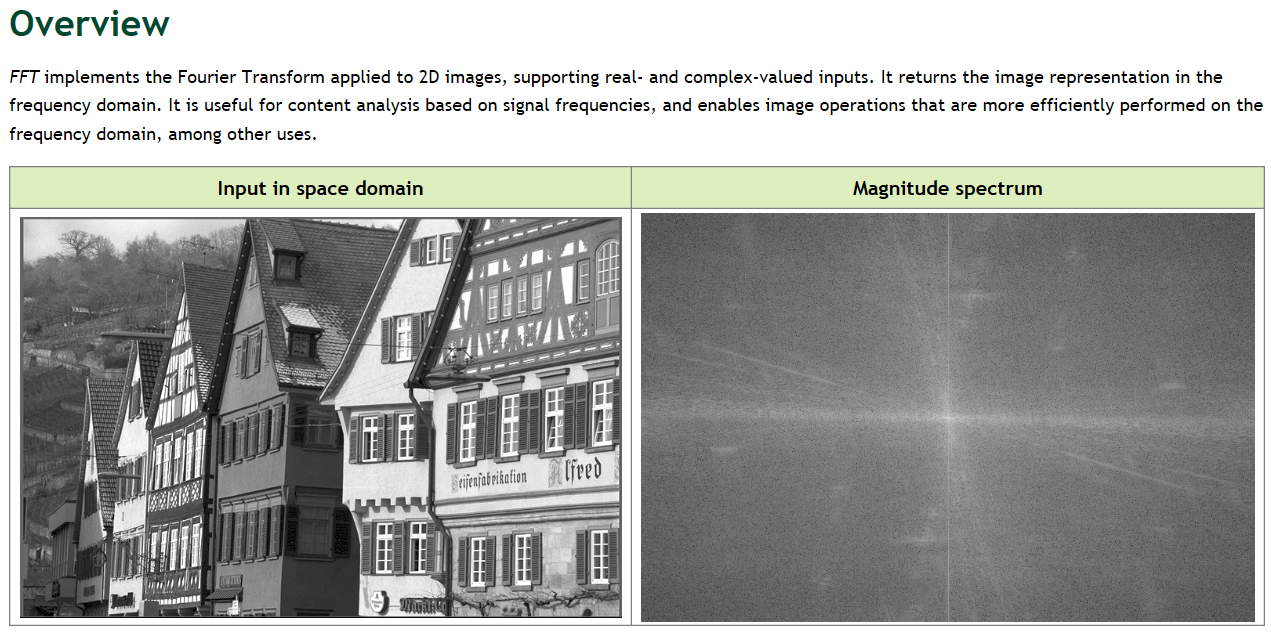

- 1.14 FFT

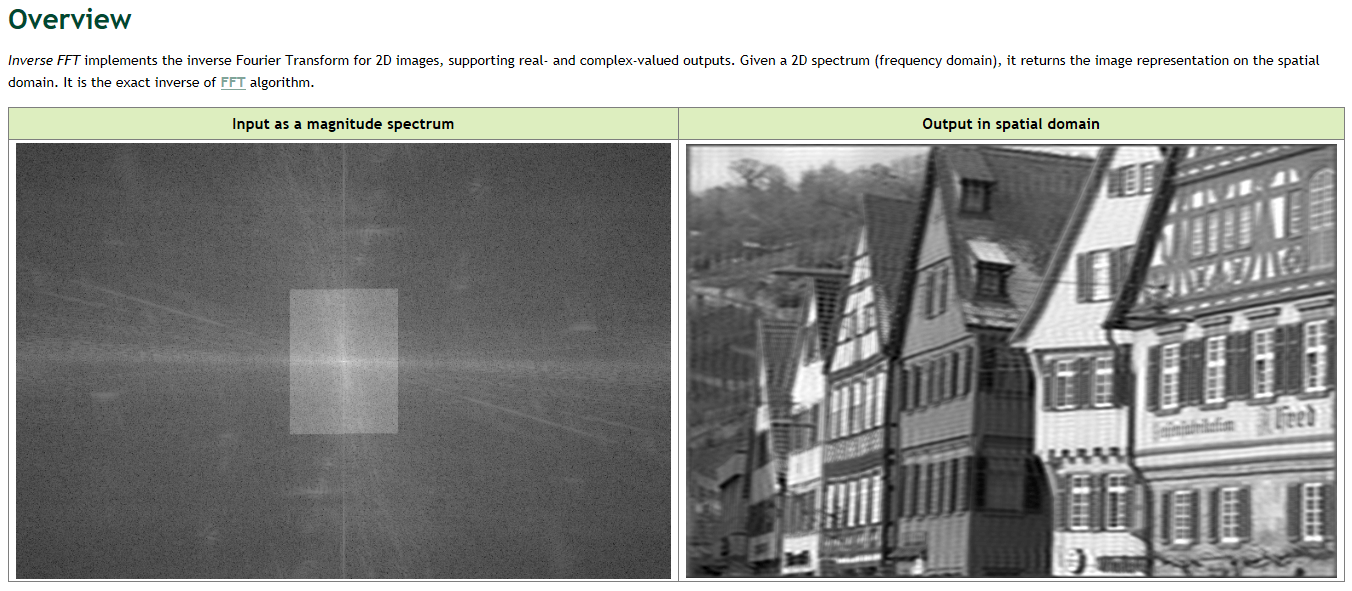

- 1.15 Inverse FFT

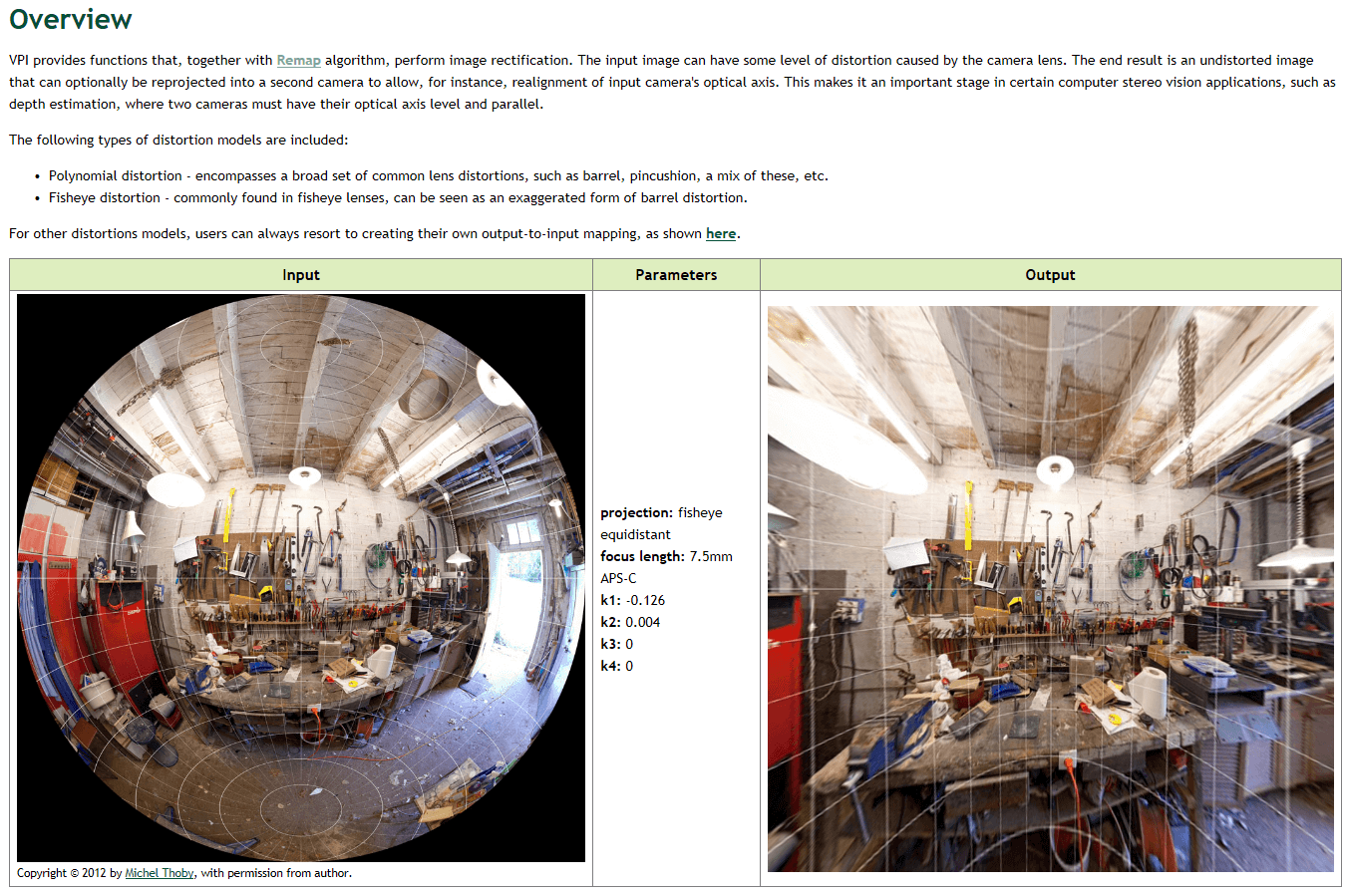

- 1.16 Lens Distortion Correction

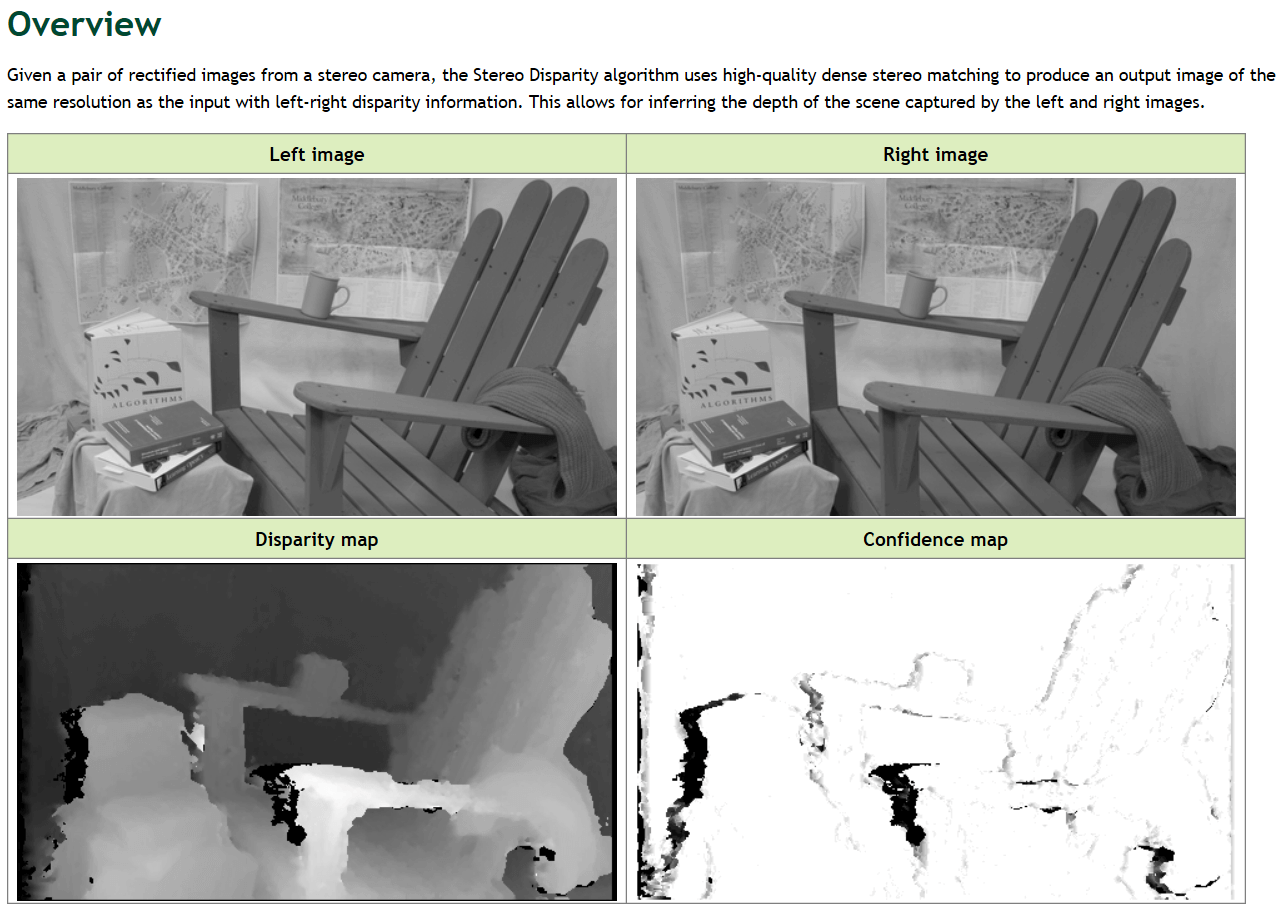

- 1.17 Stereo Disparity Estimator

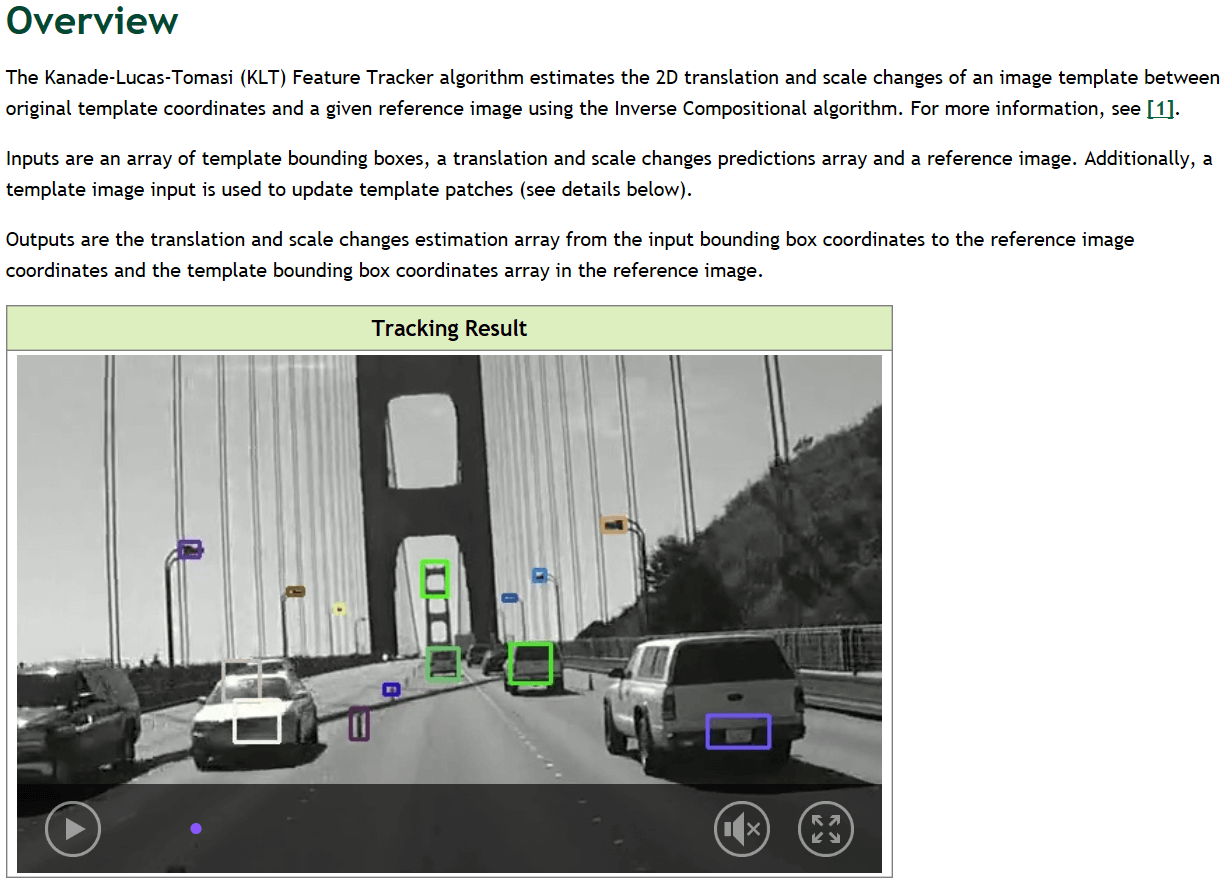

- 1.18 KLT Feature Tracker

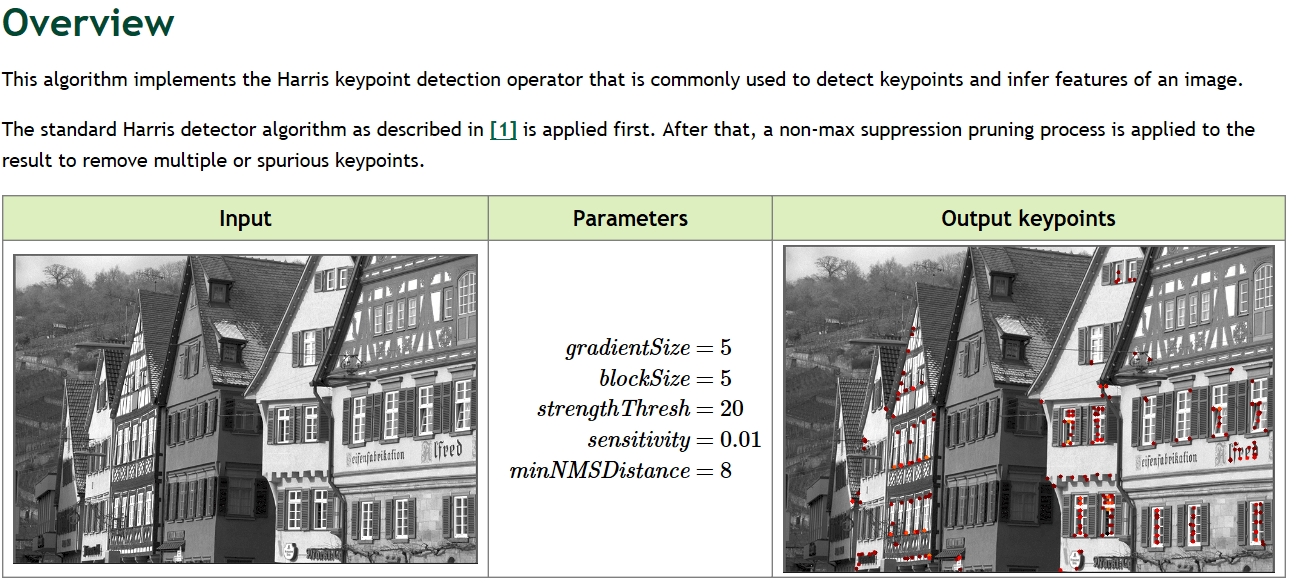

- 1.19 Harris Corner Detector

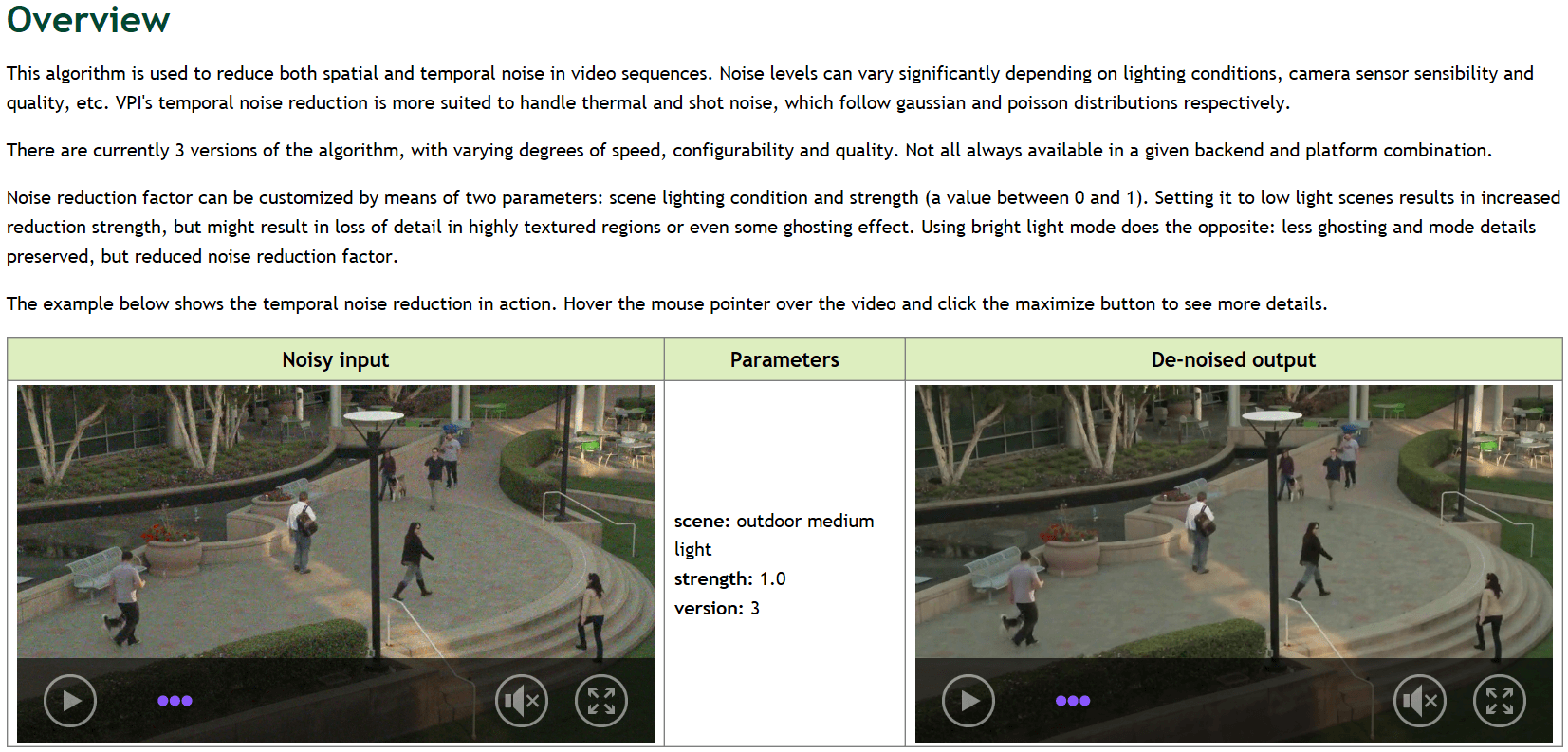

- 1.20 Temporal Noise Reduction

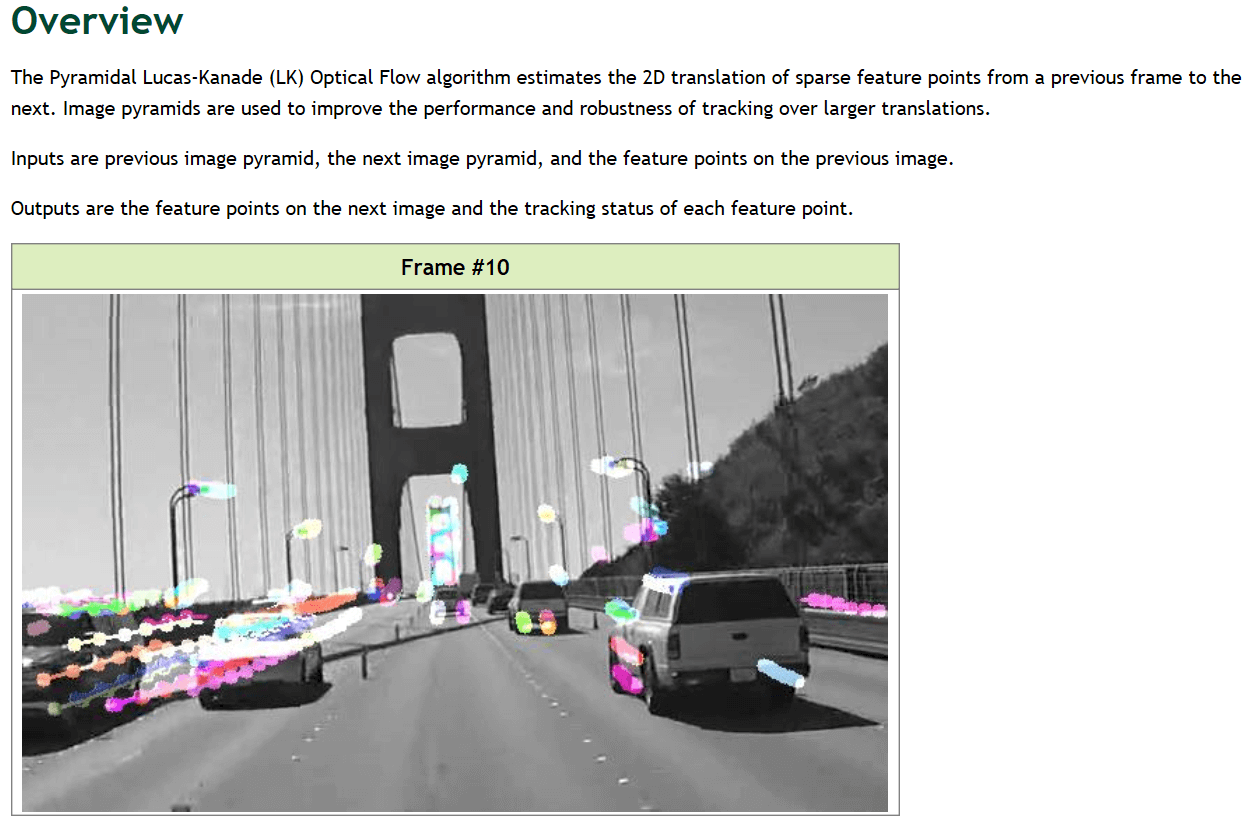

- 1.21 Pyramidal LK Optical Flow

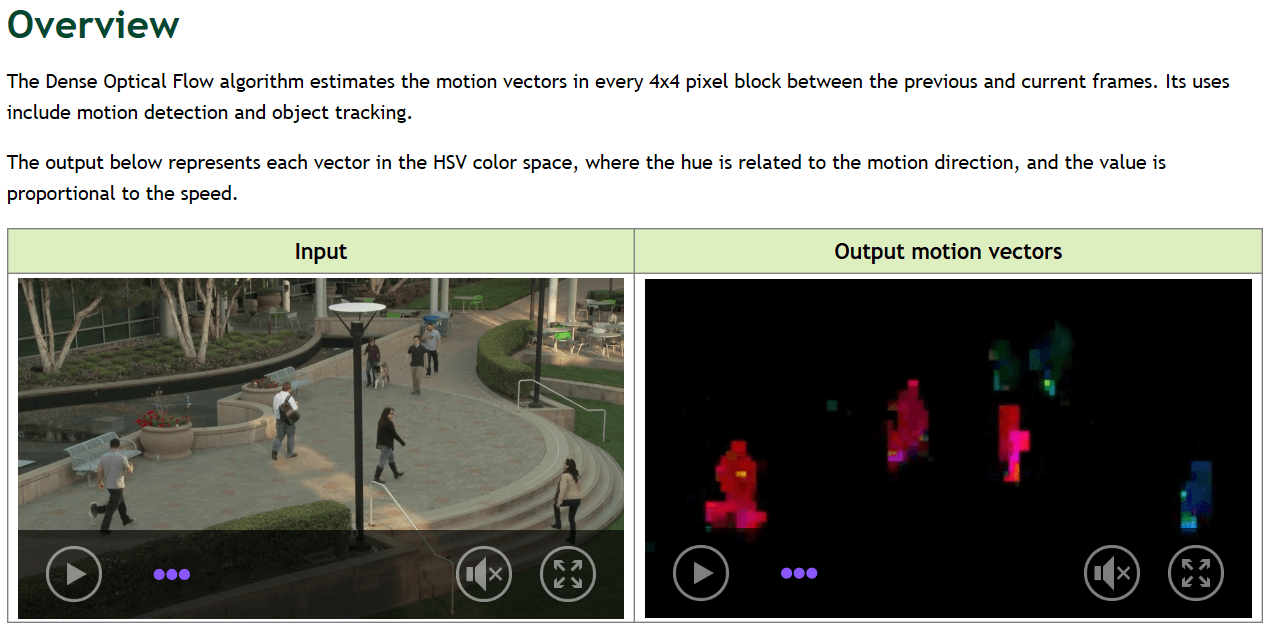

- 1.22 Dense Optical FLow

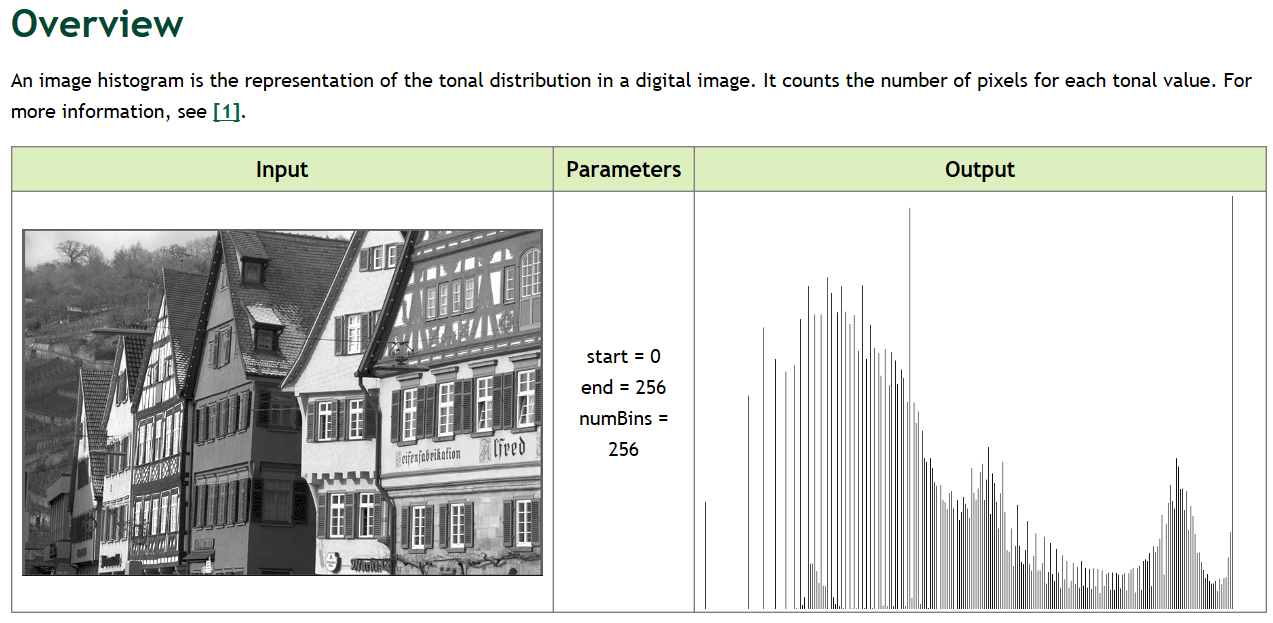

- 1.23 Image Histogram

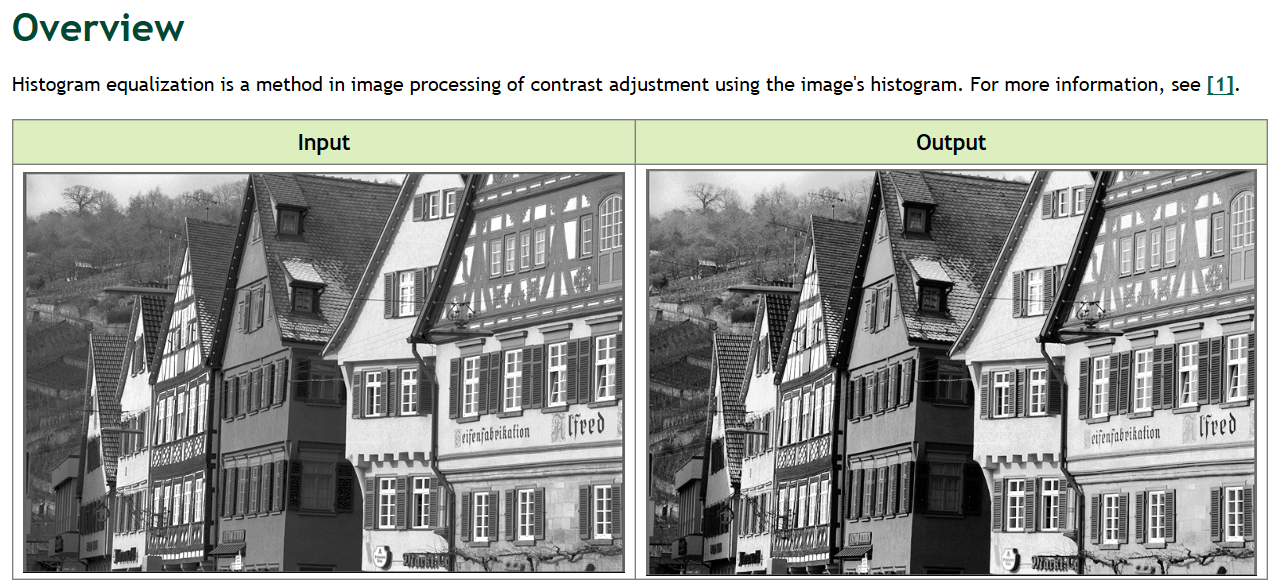

- 1.24 Equalize Histogram

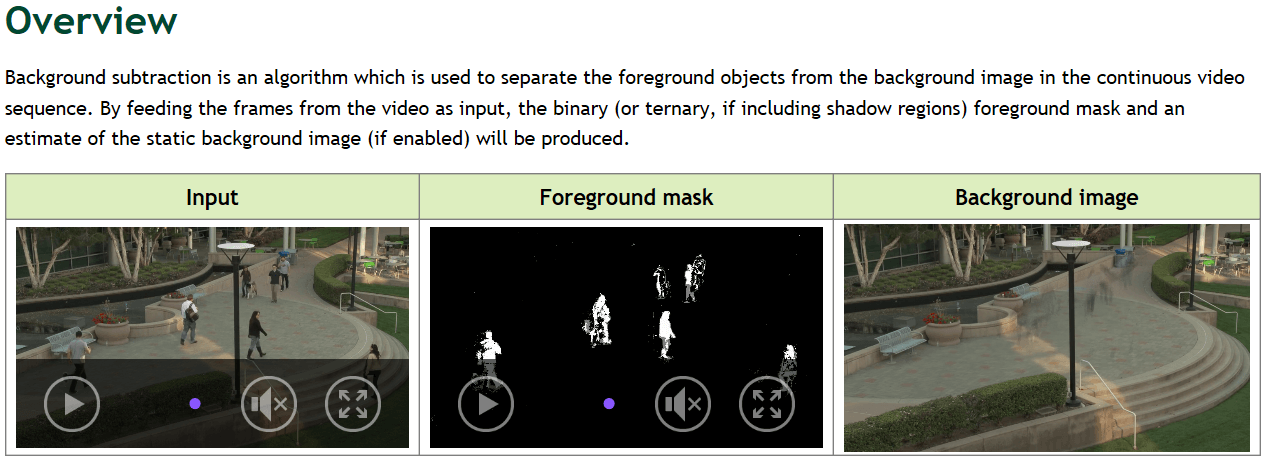

- 1.25 Background Subtractor

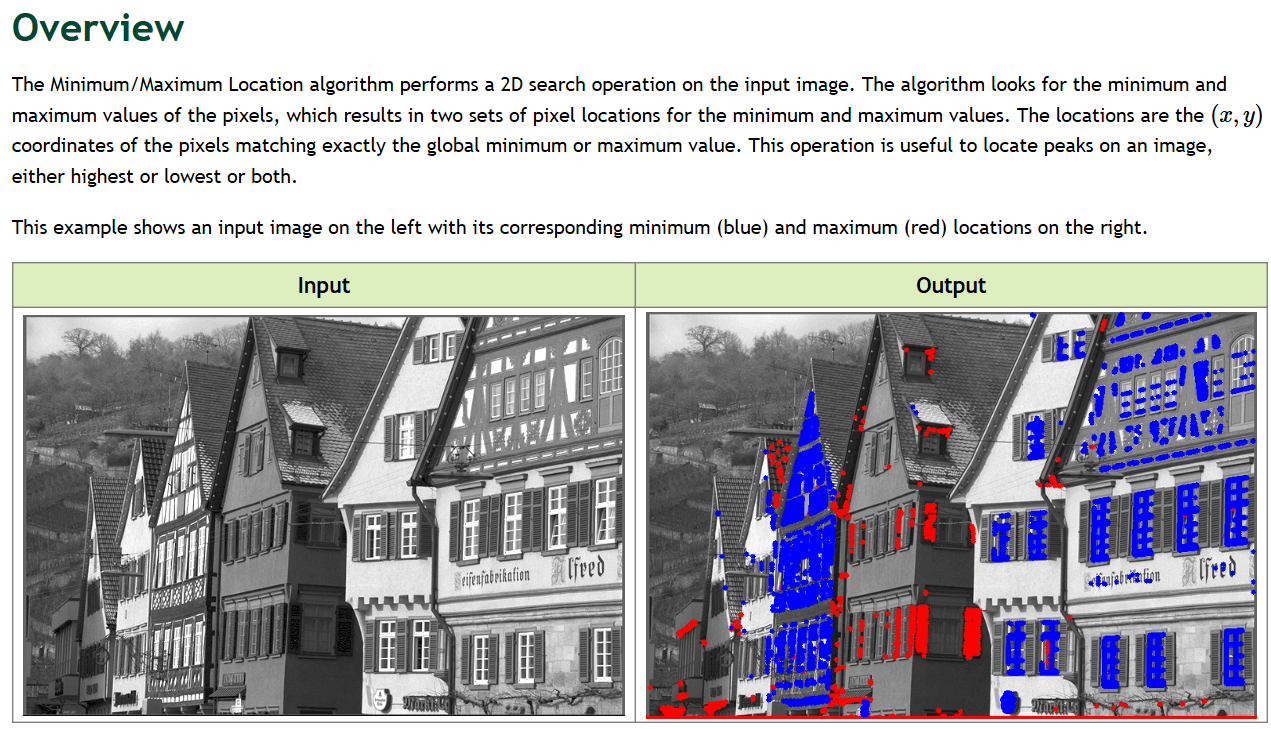

- 1.26 Minimum/Maximum Location

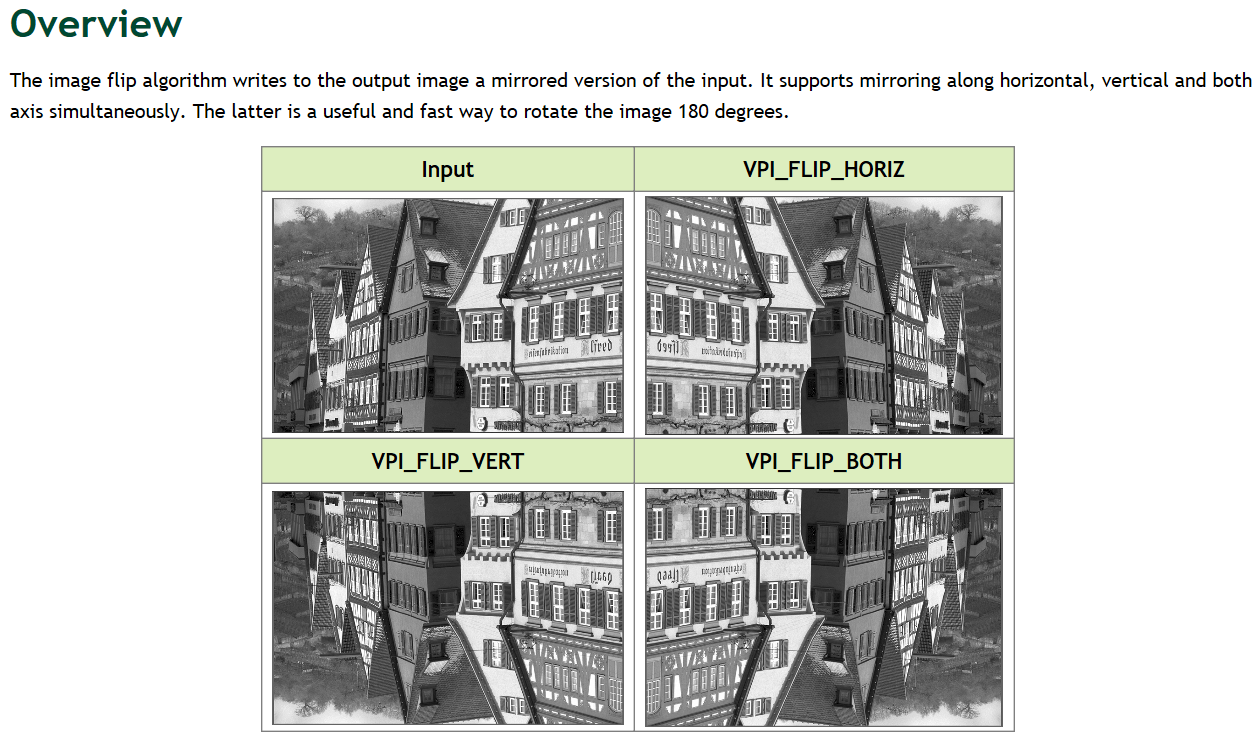

- 1.27 Image Flip

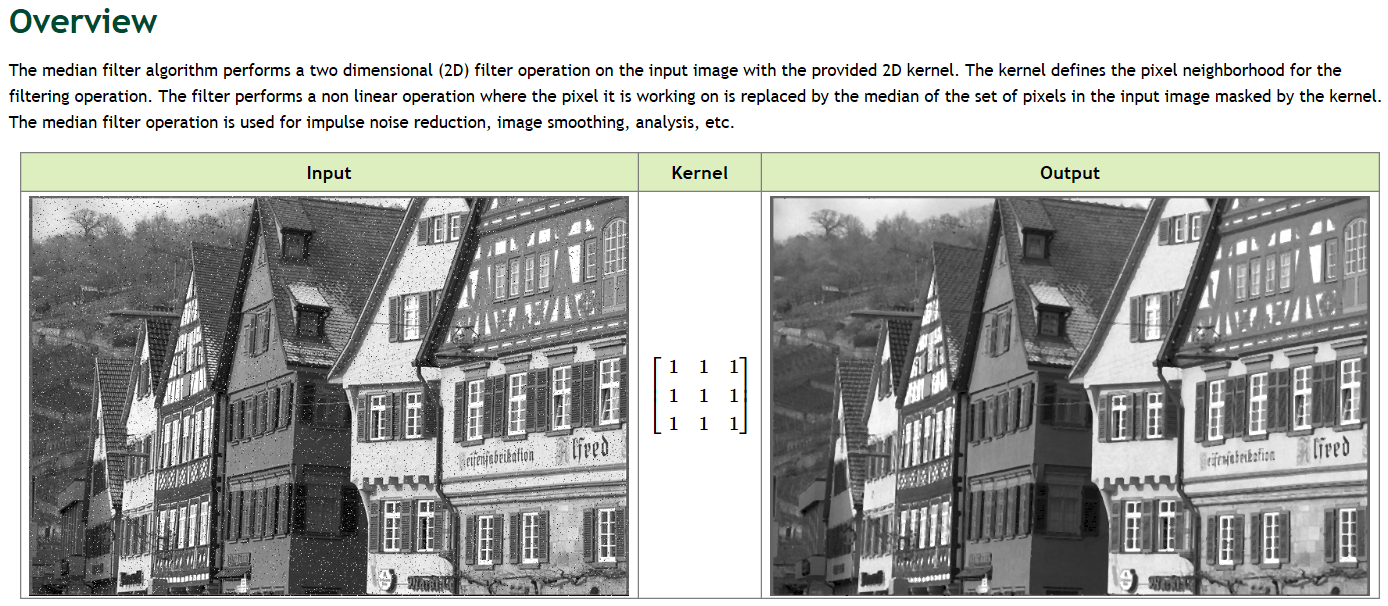

- 1.28 Median Filter

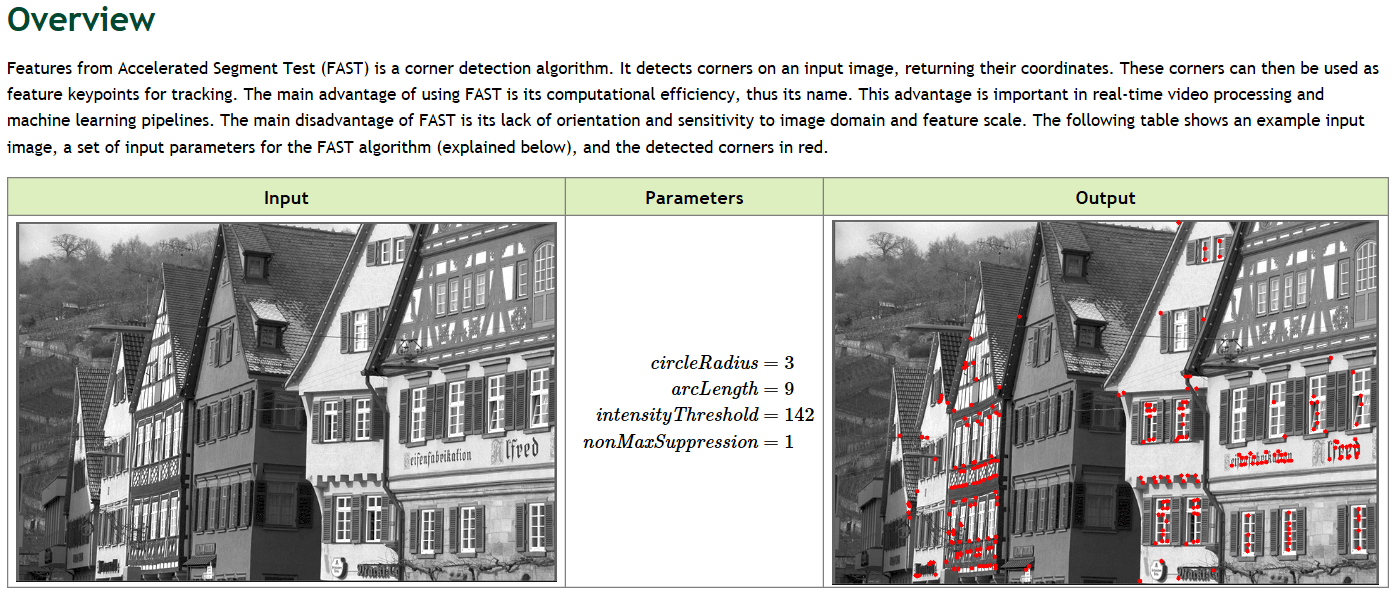

- 1.29 FAST Corner Detector

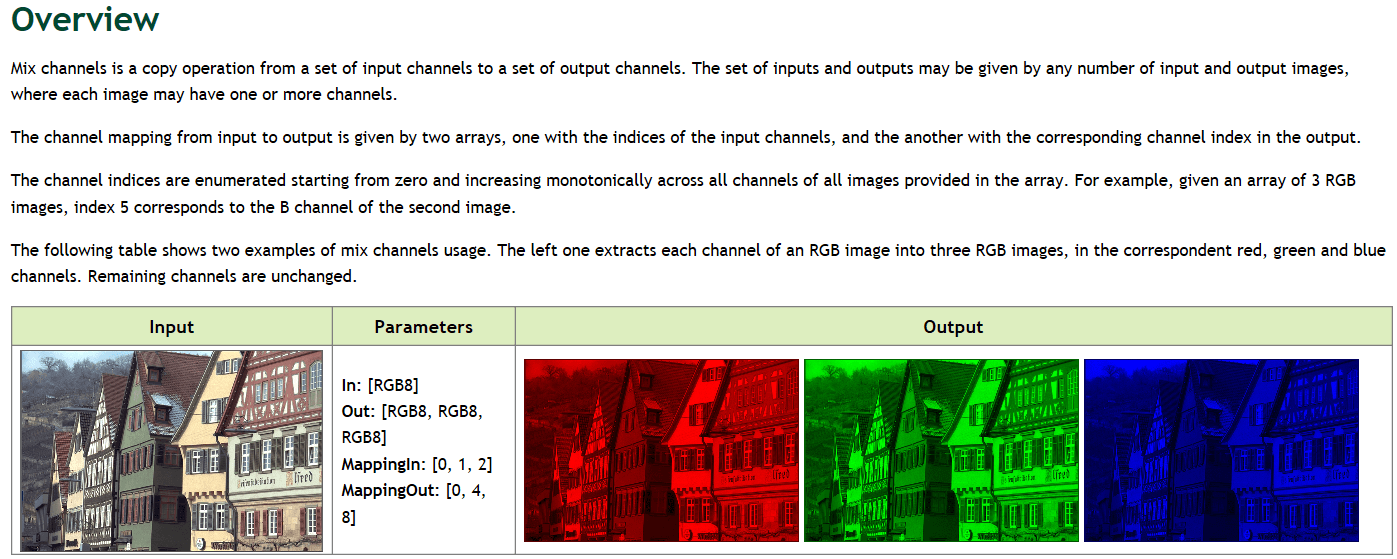

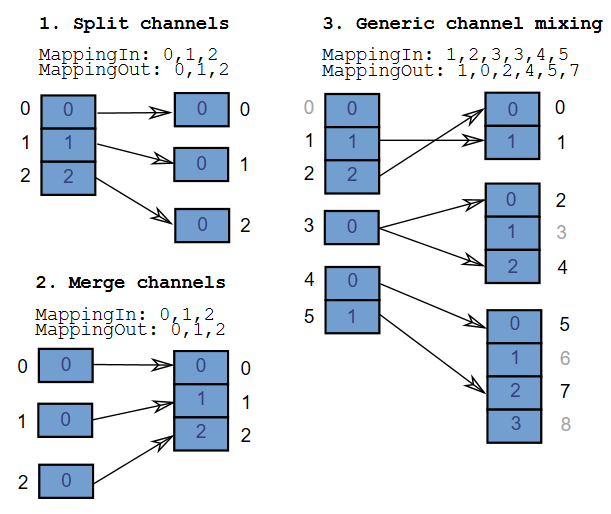

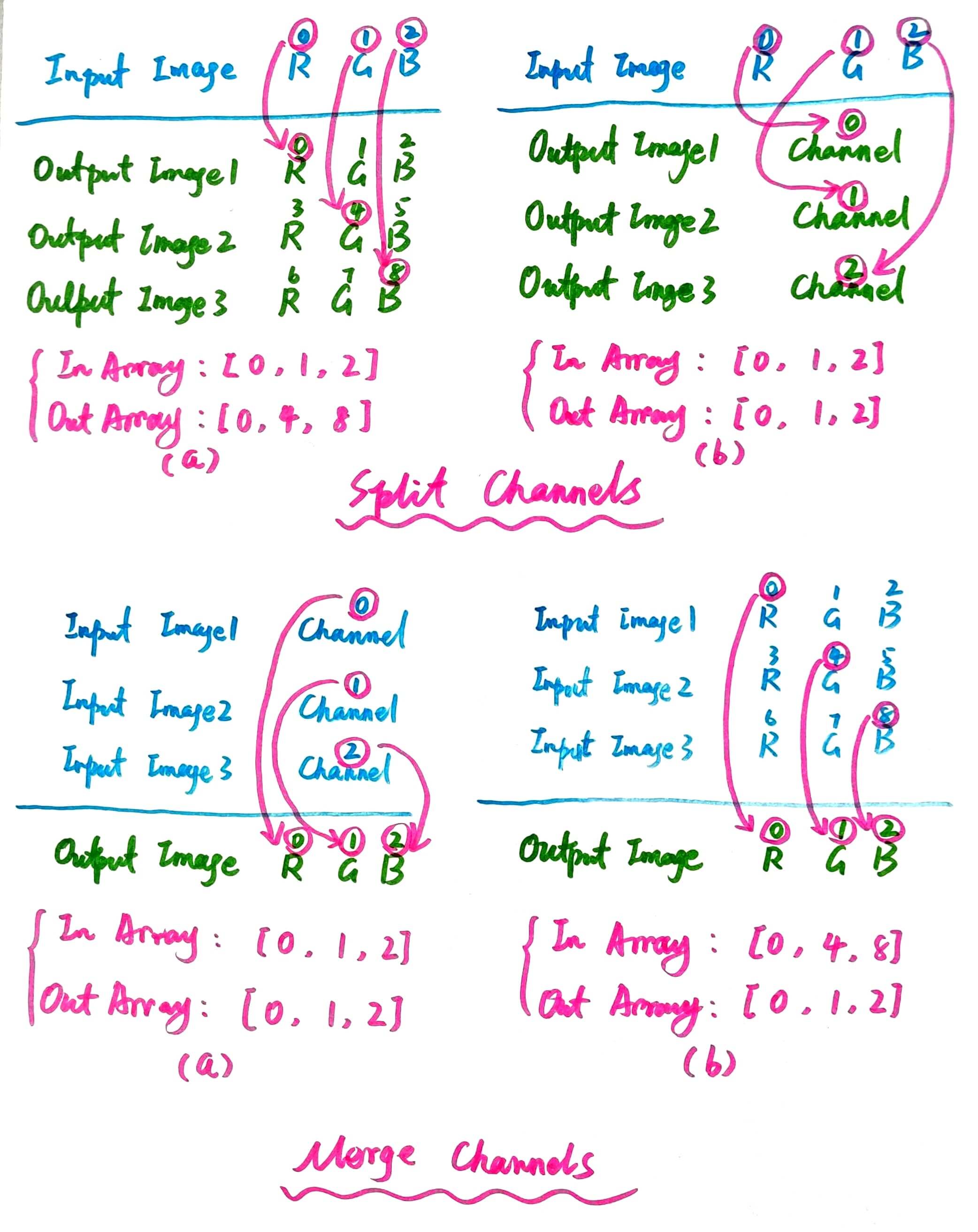

- 1.30 Mix Channels

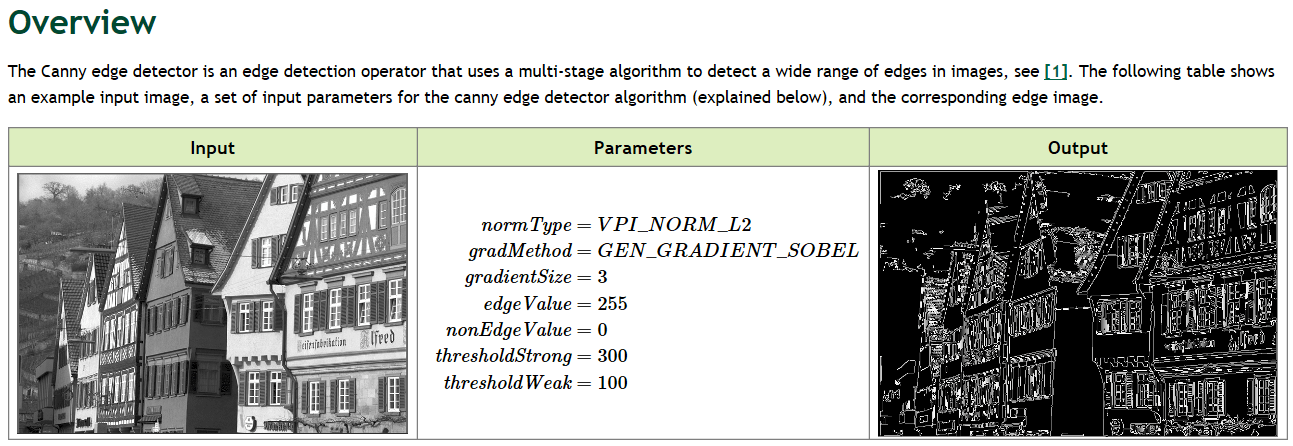

- 1.31 Canny Edge Detector

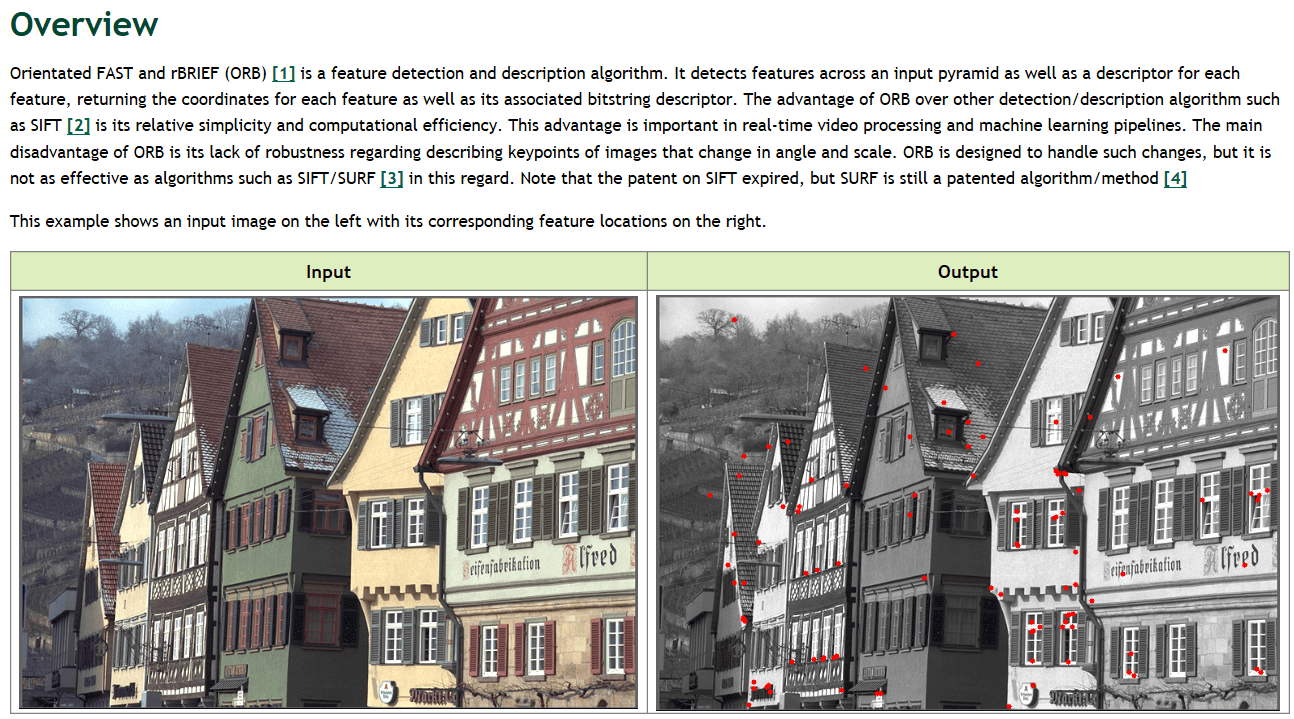

- 1.32 ORB Feature Detector

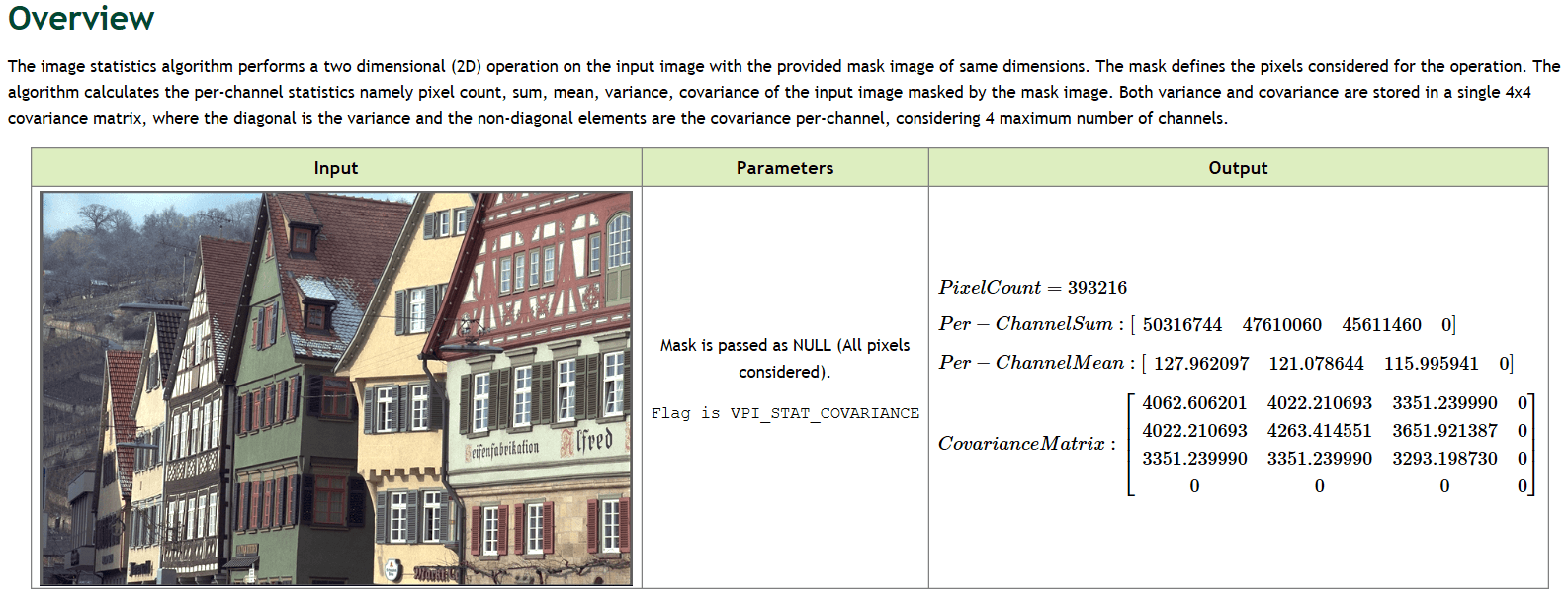

- 1.33 Image Statistics

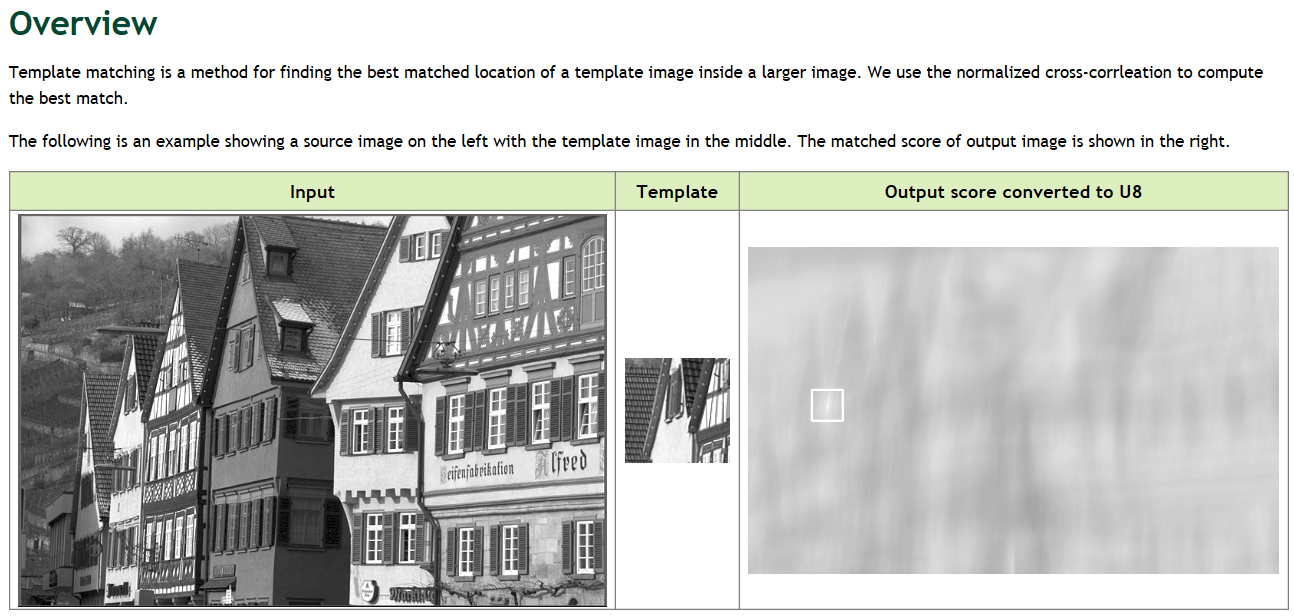

- 1.34 Template Matching

- 2.汇总表格

- 3.参考资料

在本篇笔记中,我们会简单过一遍目前VPI(2.2)支持的一些算法,看看他到底能做些什么,并展示一些官方的示例代码。因为本篇笔记内容比较多,所以并不建议从头到尾全部学习一遍(当然时间充裕也可以),而是作为工具,用到的时候来查一下相关用法。

1.支持的算法

下面列出的每个算法都有对应的官方文档。在官方文档中详细说明了函数的作用以及示例,每一步代码都有注释,很详细。在这里我们只是简单列举。如果想进一步了解,可以直接查阅对应官方文档。首先给出下面这些示例CMakeLists.txt文件。

cmake_minimum_required(VERSION 3.13)

project(vpi_algorithm_examples)

set(CMAKE_CXX_STANDARD 11)

find_package(vpi REQUIRED)

find_package(OpenCV REQUIRED)

add_executable(demo_boxFilter cpp/demo_boxFilter.cpp)

target_link_libraries(demo_boxFilter vpi ${OpenCV_LIBS})

add_executable(demo_bilateralFilter cpp/demo_bilateralFilter.cpp)

target_link_libraries(demo_bilateralFilter vpi ${OpenCV_LIBS})

add_executable(demo_gaussianFilter cpp/demo_gaussianFilter.cpp)

target_link_libraries(demo_gaussianFilter vpi ${OpenCV_LIBS})

add_executable(demo_gaussianPyramid cpp/demo_gaussianPyramid.cpp)

target_link_libraries(demo_gaussianPyramid vpi ${OpenCV_LIBS})

add_executable(demo_laplacianPyramid cpp/demo_laplacianPyramid.cpp)

target_link_libraries(demo_laplacianPyramid vpi ${OpenCV_LIBS})

add_executable(demo_erode cpp/demo_erode.cpp)

target_link_libraries(demo_erode vpi ${OpenCV_LIBS})

add_executable(demo_dilate cpp/demo_dilate.cpp)

target_link_libraries(demo_dilate vpi ${OpenCV_LIBS})

add_executable(demo_convolution cpp/demo_convolution.cpp)

target_link_libraries(demo_convolution vpi ${OpenCV_LIBS})

add_executable(demo_sepConvolution cpp/demo_sepConvolution.cpp)

target_link_libraries(demo_sepConvolution vpi ${OpenCV_LIBS})

add_executable(demo_cvtFormat cpp/demo_cvtFormat.cpp)

target_link_libraries(demo_cvtFormat vpi ${OpenCV_LIBS})

add_executable(demo_rescale cpp/demo_rescale.cpp)

target_link_libraries(demo_rescale vpi ${OpenCV_LIBS})

add_executable(demo_remap cpp/demo_remap.cpp)

target_link_libraries(demo_remap vpi ${OpenCV_LIBS})

add_executable(demo_fft cpp/demo_fft.cpp)

target_link_libraries(demo_fft vpi ${OpenCV_LIBS})

add_executable(demo_ifft cpp/demo_ifft.cpp)

target_link_libraries(demo_ifft vpi ${OpenCV_LIBS})

add_executable(demo_lensDistCorrect cpp/demo_lensDistCorrect.cpp)

target_link_libraries(demo_lensDistCorrect vpi ${OpenCV_LIBS})

add_executable(demo_stereoDisparity cpp/demo_stereoDisparity.cpp)

target_link_libraries(demo_stereoDisparity vpi ${OpenCV_LIBS})

add_executable(demo_harrisDetector cpp/demo_harrisDetector.cpp)

target_link_libraries(demo_harrisDetector vpi ${OpenCV_LIBS})

add_executable(demo_histogram cpp/demo_histogram.cpp)

target_link_libraries(demo_histogram vpi ${OpenCV_LIBS})

add_executable(demo_equalizeHist cpp/demo_equalizeHist.cpp)

target_link_libraries(demo_equalizeHist vpi ${OpenCV_LIBS})

add_executable(demo_minMaxLoc cpp/demo_minMaxLoc.cpp)

target_link_libraries(demo_minMaxLoc vpi ${OpenCV_LIBS})

add_executable(demo_imgFlip cpp/demo_imgFlip.cpp)

target_link_libraries(demo_imgFlip vpi ${OpenCV_LIBS})

add_executable(demo_medianFilter cpp/demo_medianFilter.cpp)

target_link_libraries(demo_medianFilter vpi ${OpenCV_LIBS})

add_executable(demo_FASTDetector cpp/demo_FASTDetector.cpp)

target_link_libraries(demo_FASTDetector vpi ${OpenCV_LIBS})

add_executable(demo_mixChannels cpp/demo_mixChannels.cpp)

target_link_libraries(demo_mixChannels vpi ${OpenCV_LIBS})

add_executable(demo_cannyEdge cpp/demo_cannyEdge.cpp)

target_link_libraries(demo_cannyEdge vpi ${OpenCV_LIBS})

add_executable(demo_ORBDetector cpp/demo_ORBDetector.cpp)

target_link_libraries(demo_ORBDetector vpi ${OpenCV_LIBS})

add_executable(demo_imgStatistics cpp/demo_imgStatistics.cpp)

target_link_libraries(demo_imgStatistics vpi ${OpenCV_LIBS})

add_executable(demo_templateMatching cpp/demo_templateMatching.cpp)

target_link_libraries(demo_templateMatching vpi ${OpenCV_LIBS})

下面的每段代码都经过测试,但个别示例(KLT Feature Tracker、Temporal Noise Reduction、Pyramidal LK Optical Flow、Dense Optical FLow、Background Subtractor)直接从官方文档摘录,代码不完整无法运行。IFFT示例可以运行,但因为输入的数据不对,导致输出结果不正确。之后会进一步研究用法。同时因为代码量比较大,尽管仔细检查了,但也难免有错,欢迎发现问题。为了方便使用,以下所有运行起来的代码都上传到了Github,点击查看,欢迎Start或Fork。

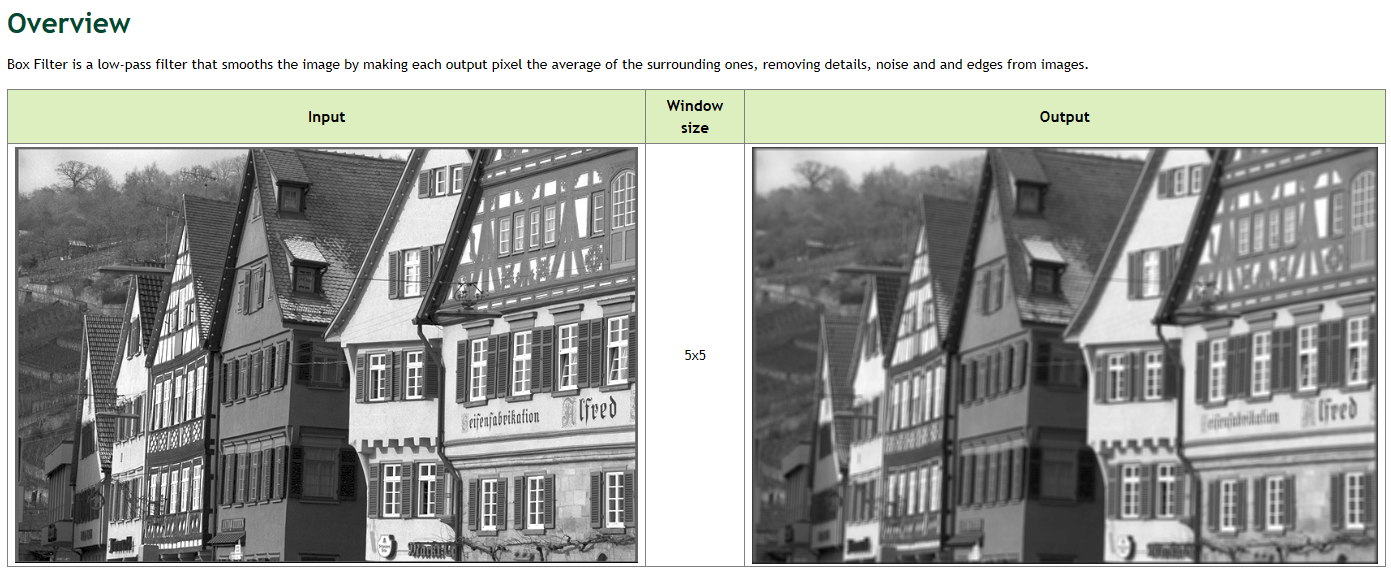

1.1 Box Filter

官方文档是这个。最简单的方形滤波器,是一个低通滤波器,实现对图像的平滑(局部窗口取平均赋值),不支持自定义滤波器内容。直观效果如下。

C++需引用

C++需引用vpi/algo/BoxFilter.h,名字为vpiSubmitBoxFilter(),Python需导入vpi包,名字为.box_filter()。

1.1.1 C++接口

C++用法如下,包含初始化、执行和销毁三个阶段:

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/BoxFilter.h> // BoxFilter头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitBoxFilter(stream, VPI_BACKEND_CUDA, input, output, 5, 5, VPI_BORDER_ZERO);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// step9 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step10 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_boxFilter.jpg", out_mat);

// step11 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step12 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.1.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.box_filter(5, border=vpi.Border.ZERO)

# step4 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_boxFilter.jpg", outData)

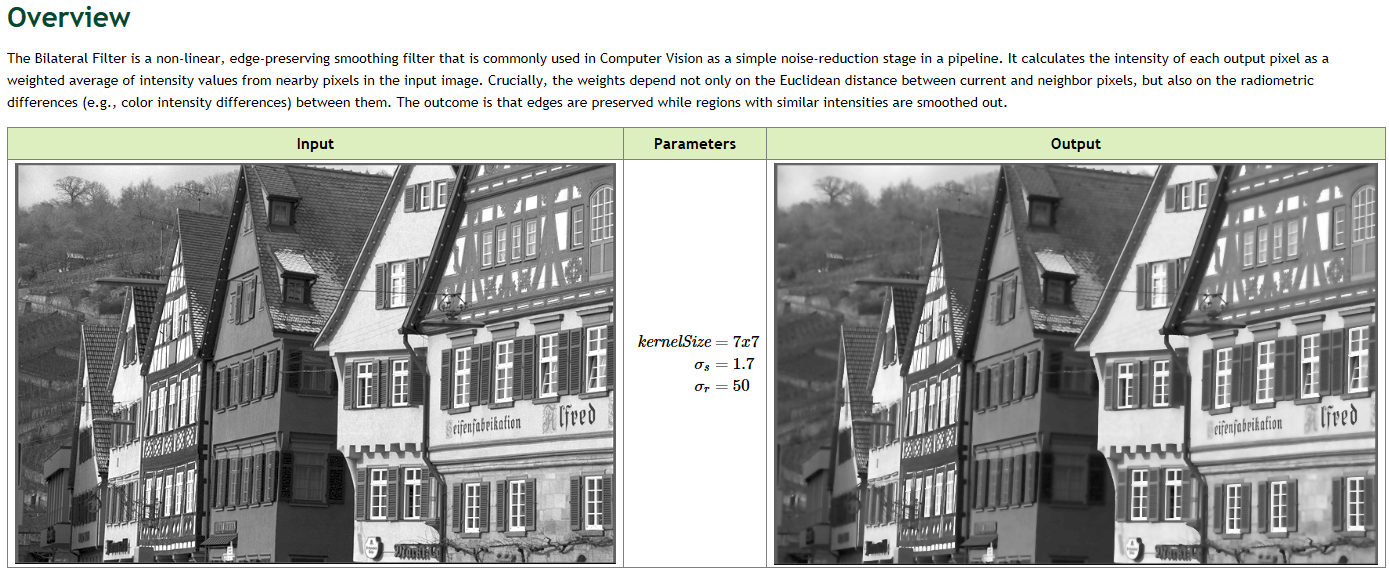

1.2 Bilateral Filter

官方文档是这个。经典的双边滤波器。可以在保留影像边缘信息的同时对噪声进行一定程度的滤除。可以控制滤波器的窗口大小、强度参数。效果如下。

C++需引用

C++需引用vpi/algo/BilateralFilter.h,名字为vpiSubmitBilateralFilter(),Python需导入vpi包,名字为.bilateral_filter()。

1.2.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/BilateralFilter.h> // BilateralFilter头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitBilateralFilter(stream, VPI_BACKEND_CUDA, input, output, 7, 50, 1.7, VPI_BORDER_ZERO);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// step9 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step10 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_bilateralFilter.jpg", out_mat);

// step11 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step12 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.2.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.bilateral_filter(5, 7, 50, border=vpi.Border.ZERO)

# step4 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_bilateralFilter.jpg", outData)

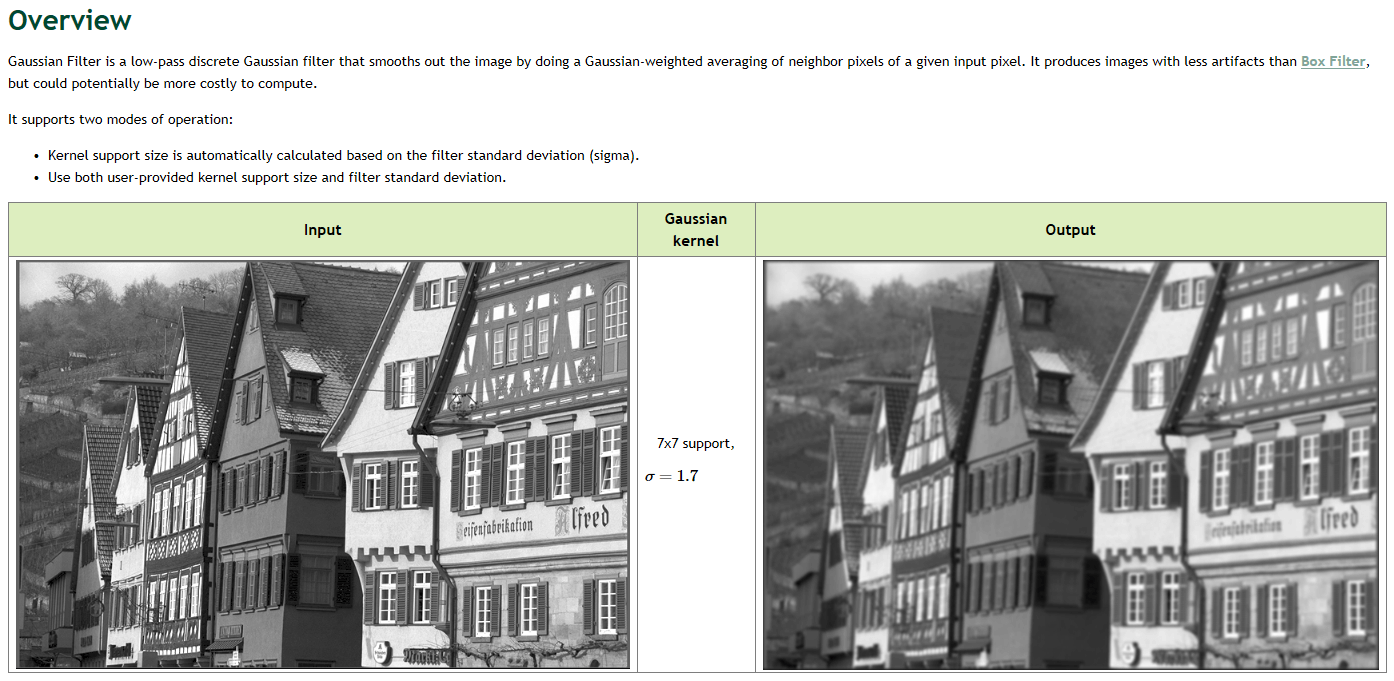

1.3 Gaussian Filter

官方文档是这个。经典高斯滤波器。支持对滤波器大小和强度的设置,效果如下。

C++需引用

C++需引用vpi/algo/GaussionFilter.h,名字为vpiSubmitGaussianFilter(),Python需导入vpi包,名字为.gaussian_filter()。

1.3.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/GaussianFilter.h> // GaussianFilter头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitGaussianFilter(stream, VPI_BACKEND_CPU, input, output, 7, 7, 1.7, 1.7, VPI_BORDER_ZERO);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// step9 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step10 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_gaussianFilter.jpg", out_mat);

// step11 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step12 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.3.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.gaussian_filter(7, 1.7, border=vpi.Border.ZERO)

# step4 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_gaussianFilter.jpg", outData)

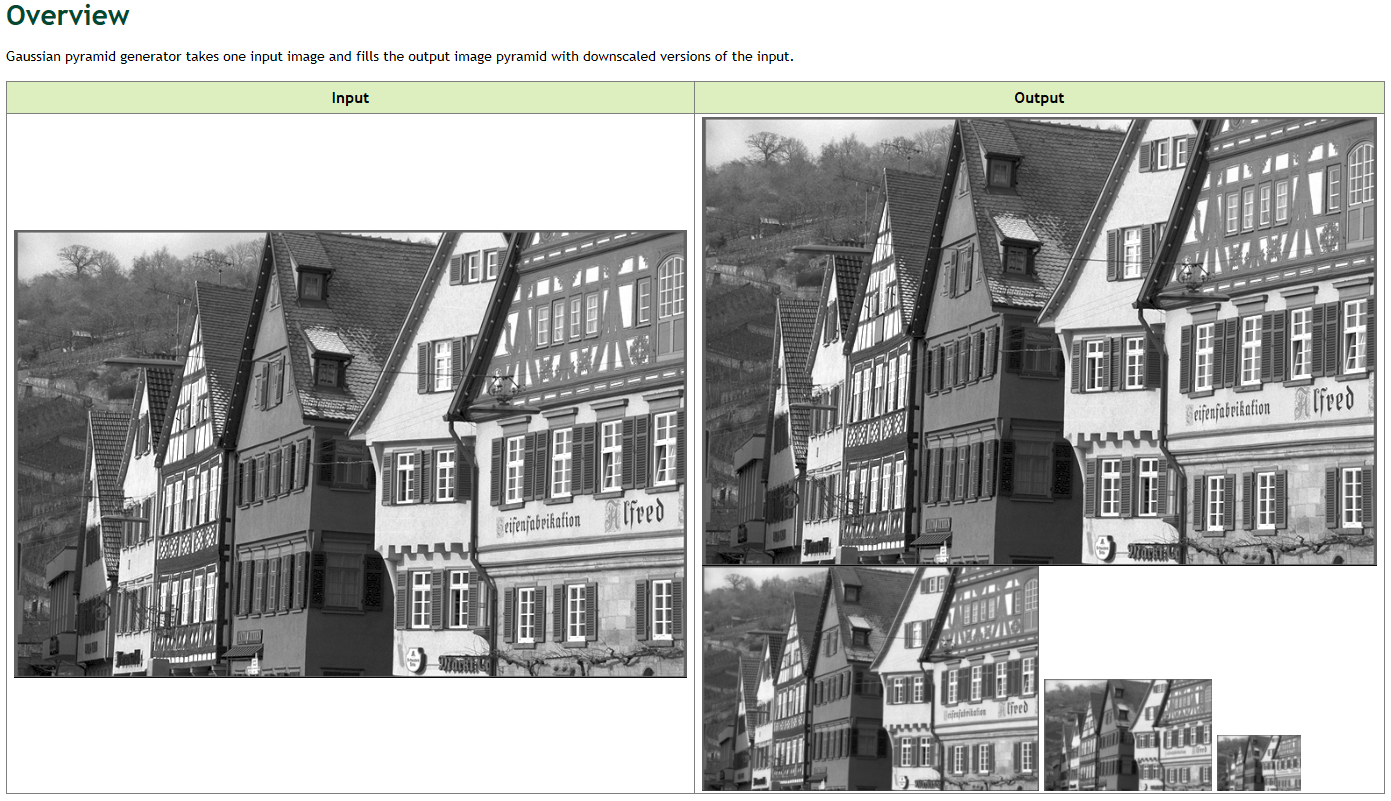

1.4 Gaussian Pyramid Generator

官方文档是这个。用于构建高斯金字塔,主要包含金字塔层数和缩放倍数两个核心参数。效果如下。

C++需引用

C++需引用vpi/Pyramid.h和vpi/algo/GaussianPyramid.h,名字为vpiSubmitGaussianPyramidGenerator(),Python需导入vpi包,名字为.gaussian_pyramid()。

1.4.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/GaussianPyramid.h> // GaussianPyramid头文件

#include <vpi/Pyramid.h> // VPI Pyramid类头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建金字塔对象

VPIPyramid output;

vpiPyramidCreate(w, h, type, 4, 0.5, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitGaussianPyramidGenerator(stream, VPI_BACKEND_CPU, input, output, VPI_BORDER_CLAMP);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step9 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiPyramidDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.4.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.gaussian_pyramid(4)

1.5 Laplacian Pyramid Generator

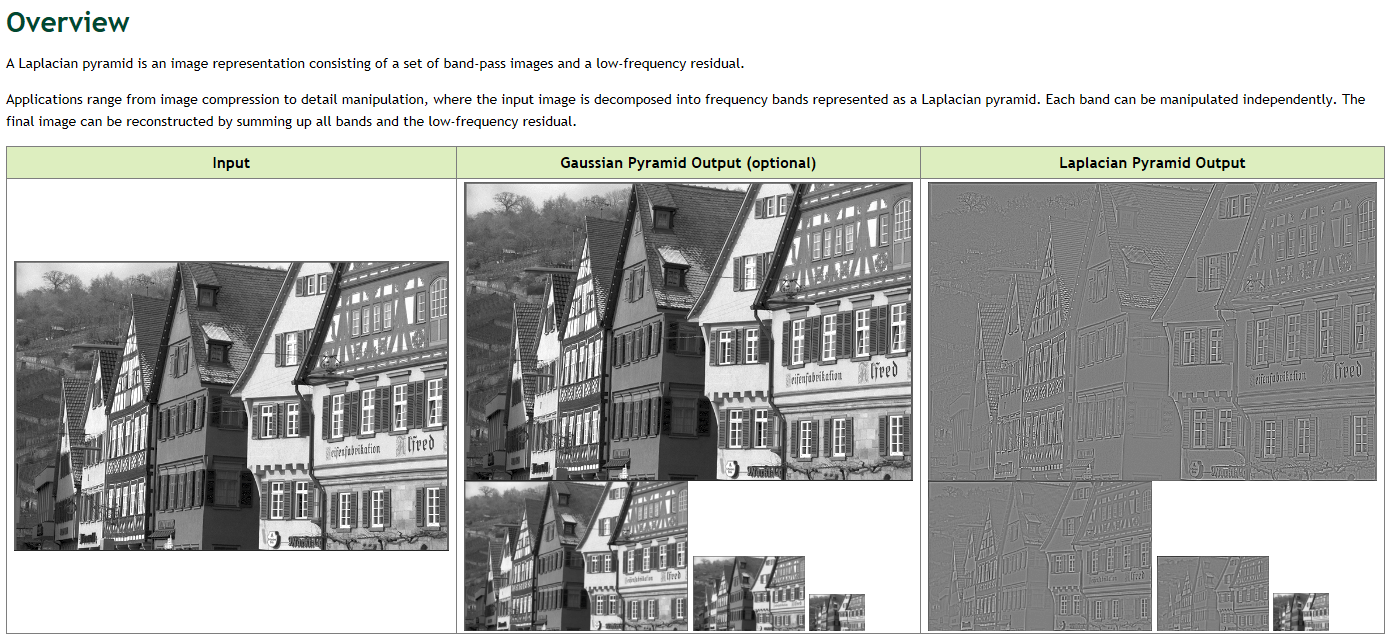

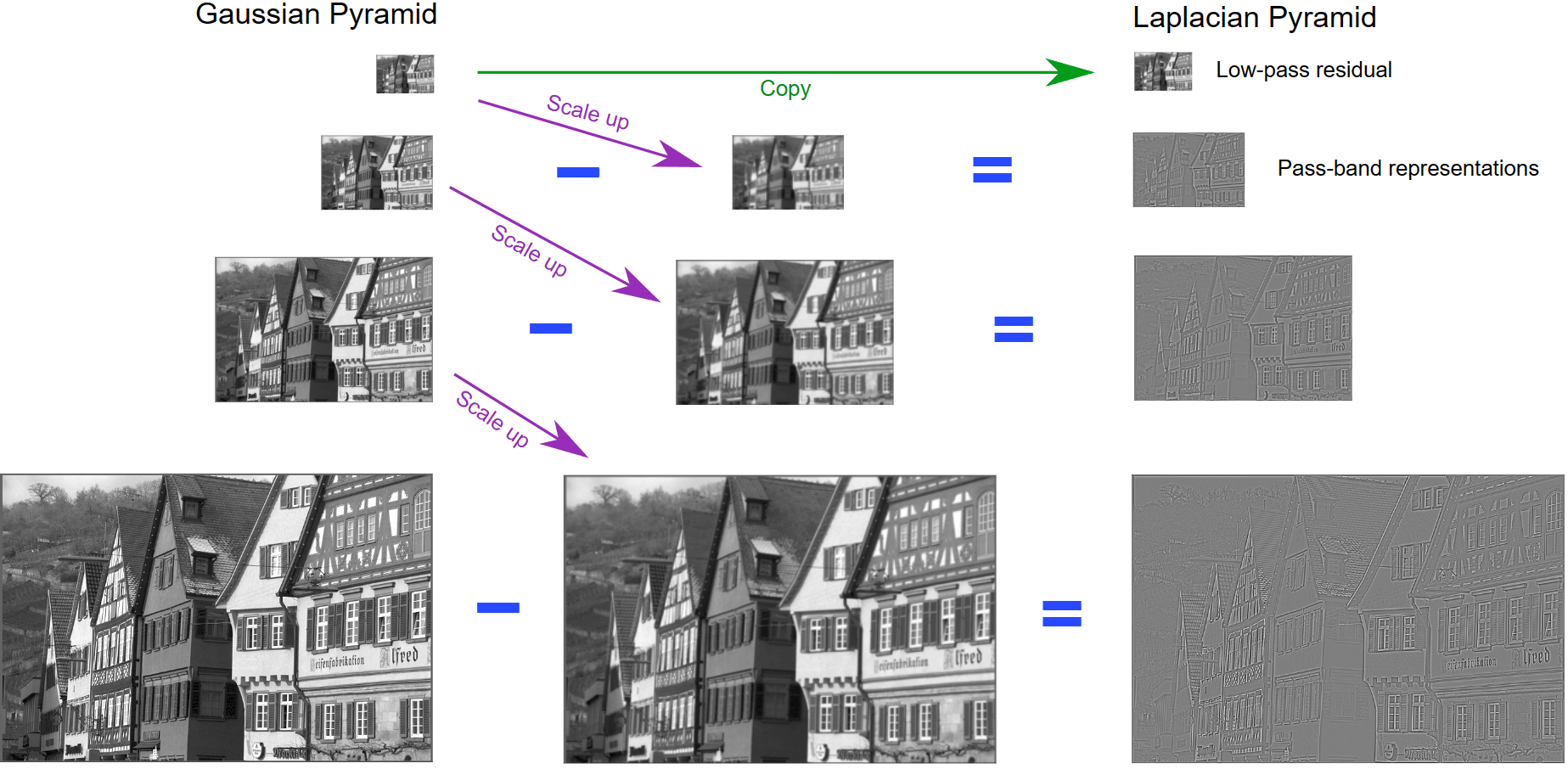

官方文档是这个。用于构建拉普拉斯金字塔。效果如下。

在VPI中拉普拉斯金字塔是通过高斯金字塔上采样然后差分得到的,如下图所示。

在VPI中拉普拉斯金字塔是通过高斯金字塔上采样然后差分得到的,如下图所示。

C++需引用

C++需引用vpi/Pyramid.h和vpi/algo/LaplacianPyramid.h,名字为vpiSubmitLaplacianPyramidGenerator(),Python需导入vpi包,名字为.laplacian_pyramid()。

1.5.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/LaplacianPyramid.h> // LaplacianPyramid头文件

#include <vpi/Pyramid.h> // VPI Pyramid类头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建金字塔对象

VPIPyramid output;

vpiPyramidCreate(w, h, type, 4, 0.5, 0, &output);

VPIPyramid gaussianPyr;

vpiPyramidCreate(w, h, type, 4, 0.5, 0, &gaussianPyr);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitLaplacianPyramidGenerator(stream, VPI_BACKEND_CPU, input, output, gaussianPyr, VPI_BORDER_CLAMP);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step9 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiPyramidDestroy(output);

vpiPyramidDestroy(gaussianPyr);

// -------------------------------------------------------------------

return 0;

}

1.5.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

gaussian = vpi.Pyramid(input.size, input.format, 4)

with vpi.Backend.CUDA:

output = input.laplacian_pyramid(4, out_gaussian=gaussian)

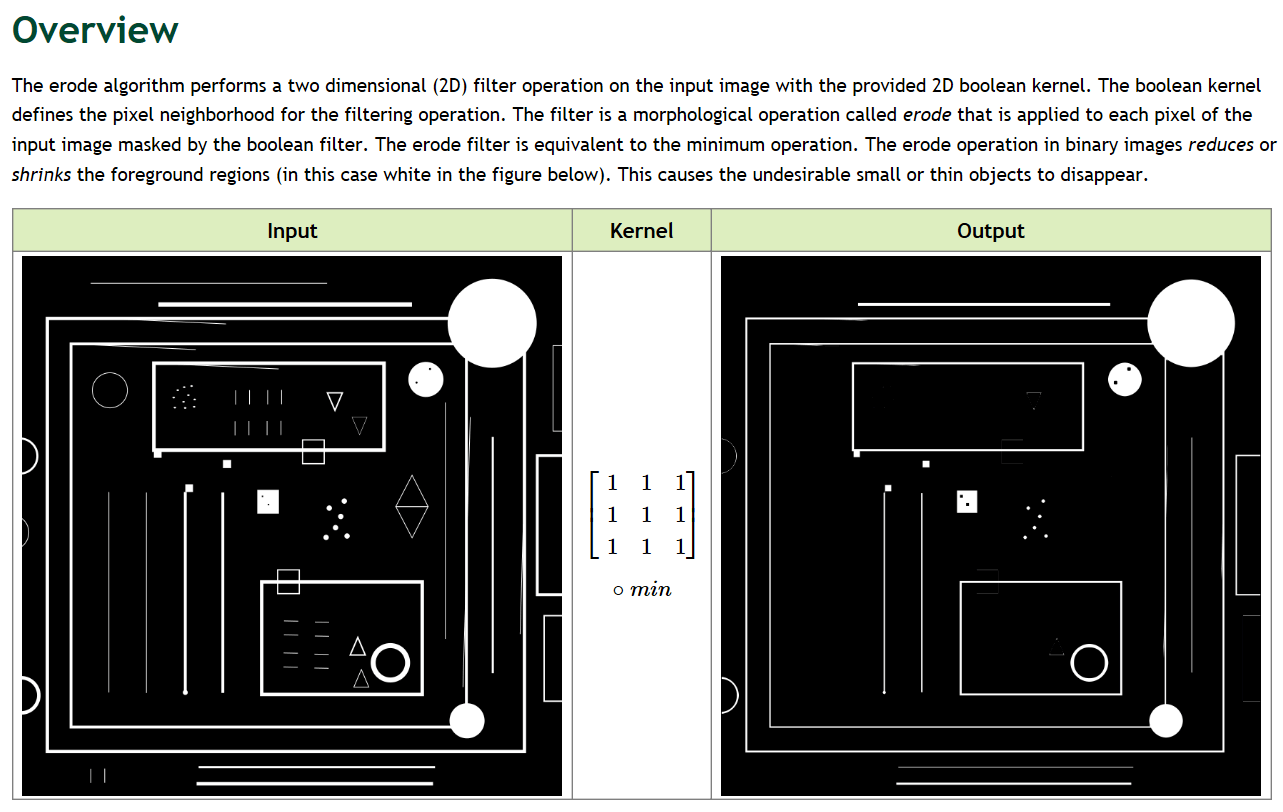

1.6 Erode

官方文档是这个。经典腐蚀操作。支持手动修改卷积核大小。效果如下。

C++需引用

C++需引用vpi/algo/MorphologicalFilter.h,名字为vpiSubmitErode(),Python需导入vpi包,名字为.erode()。

1.6.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/MorphologicalFilter.h> // MorphologicalFilter头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建卷积核

int8_t kernel[3 * 3] = {1, 1, 1,

1, 1, 1,

1, 1, 1};

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitErode(stream, VPI_BACKEND_CPU, input, output, kernel, 3, 3, VPI_BORDER_ZERO);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_erode.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.6.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建卷积核

kernel = [[1, 1, 1],

[1, 1, 1],

[1, 1, 1]]

# step4 执行操作

with vpi.Backend.CUDA:

output = input.erode(kernel, border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_erode.jpg", outData)

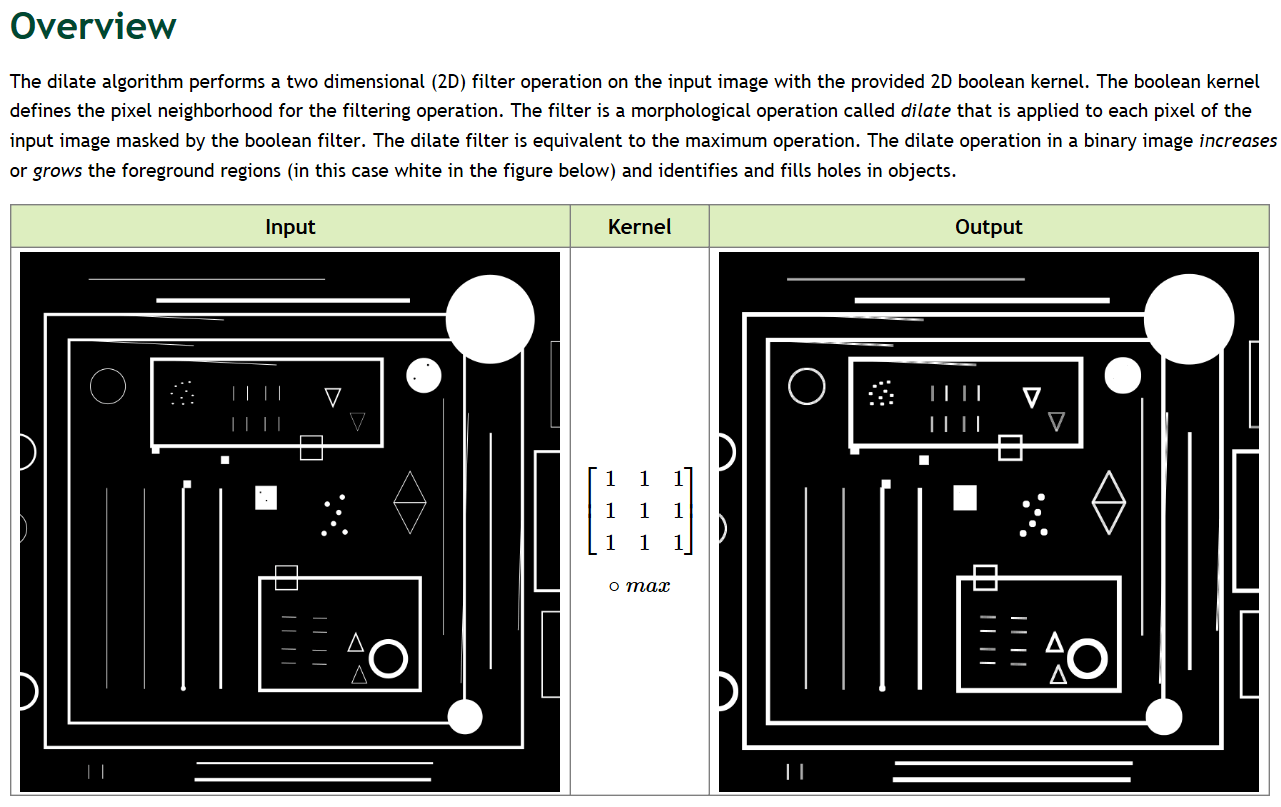

1.7 Dilate

官方文档是这个。经典膨胀操作。支持手动修改卷积核大小。效果如下。

C++需引用

C++需引用vpi/algo/MorphologicalFilter.h,名字为vpiSubmitDilate(),Python需导入vpi包,名字为.dilate()。

1.7.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/MorphologicalFilter.h> // MorphologicalFilter头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建卷积核

int8_t kernel[3 * 3] = {1, 1, 1,

1, 1, 1,

1, 1, 1};

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitDilate(stream, VPI_BACKEND_CPU, input, output, kernel, 3, 3, VPI_BORDER_ZERO);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_dilate.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.7.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建卷积核

kernel = [[1, 1, 1],

[1, 1, 1],

[1, 1, 1]]

# step4 执行操作

with vpi.Backend.CUDA:

output = input.dilate(kernel, border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_dilate.jpg", outData)

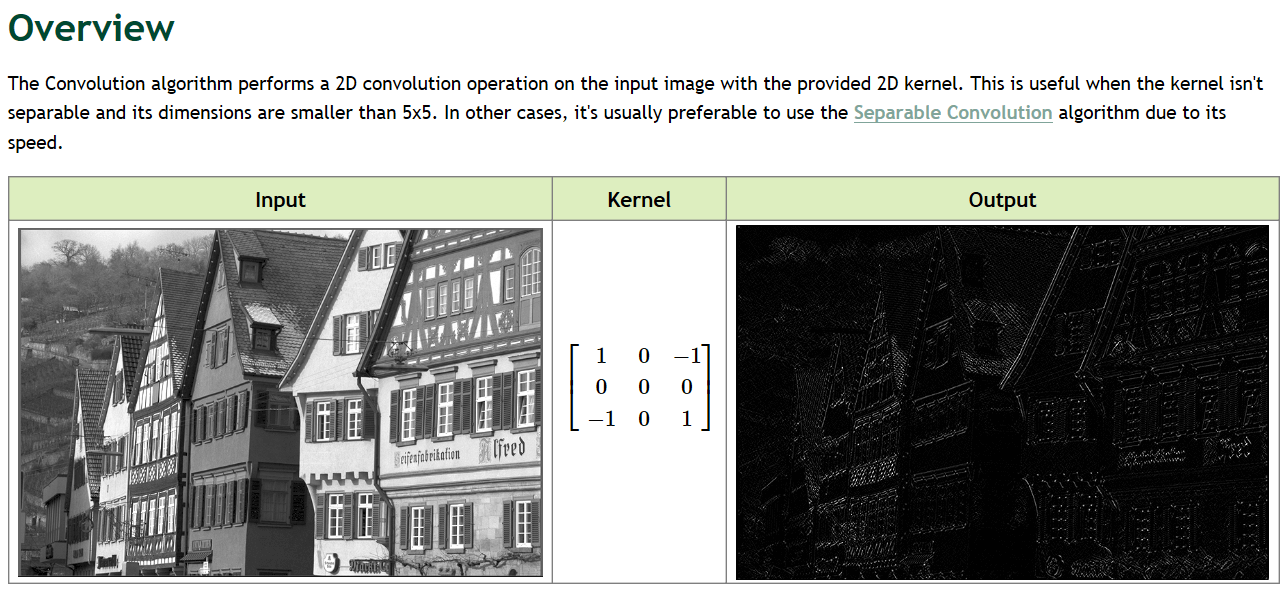

1.8 Convolution

官方文档是这个。针对常规的卷积操作开发的函数。在VPI中,可以用该函数进行小于5×5的卷积(建议),如果卷积核过大,这个函数性能可能会下降,推荐可分离卷积。效果如下。

C++需引用

C++需引用vpi/algo/Convolution.h,名字为vpiSubmitConvolution(),Python需导入vpi包,名字为.convolution()。

1.8.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/Convolution.h> // Convolution头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建卷积核

float kernel[3 * 3] = {1, 0, -1,

0, 0, 0,

-1, 0, 1};

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitConvolution(stream, VPI_BACKEND_CPU, input, output, kernel, 3, 3, VPI_BORDER_ZERO);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_conv.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.8.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建卷积核

kernel = [[1, 0, -1],

[0, 0, 0],

[-1, 0, 1]]

# step4 执行操作

with vpi.Backend.CUDA:

output = input.convolution(kernel, border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_conv.jpg", outData)

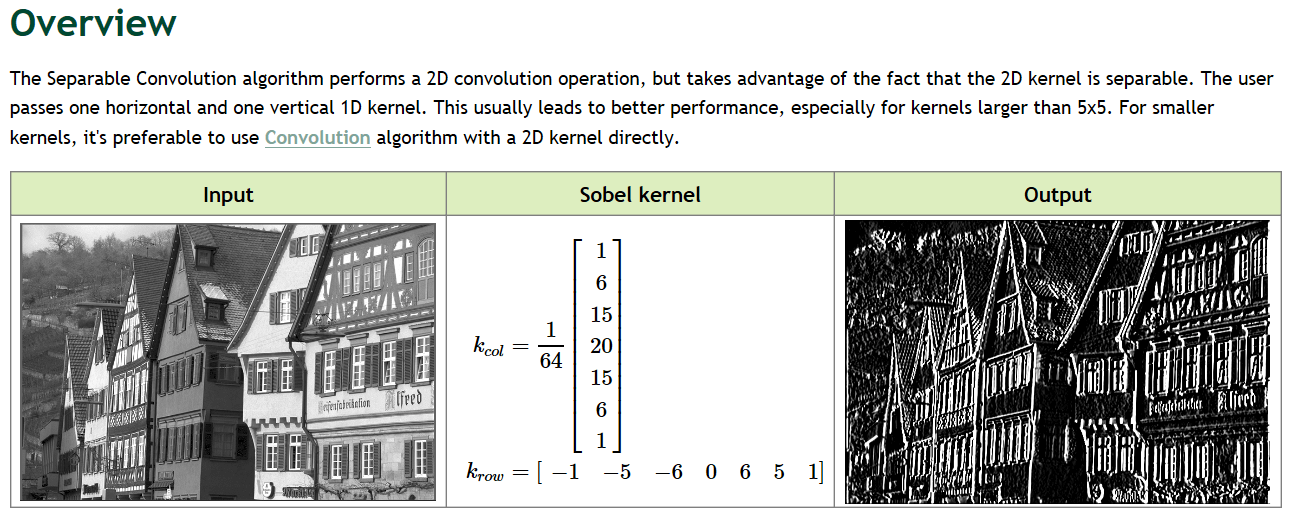

1.9 Separable Convolution

官方文档是这个。可分离卷积。就是将常规的二维卷积分离成一个水平和一个竖直的分量。因为二维卷积本质上是一个矩阵,而一个m×n的矩阵可以由一个m×1的矩阵和一个1×n的矩阵相乘得到。根据官方文档,相比于上面提到的Convolution。可分离卷积在面对大尺度的卷积核时性能会更好。效果如下。

C++需引用

C++需引用vpi/algo/Convolution.h,名字为vpiSubmitSeparableConvolution(),Python需导入vpi包,名字为.convolution()。

1.9.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/Convolution.h> // Convolution头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建卷积核

float sobel_row[7] = {-1, -5, -6, 0, +6, +5, +1};

float sobel_col[7] = {1 / 64.f, 6 / 64.f, 15 / 64.f, 20 / 64.f, 15 / 64.f, 6 / 64.f, 1 / 64.f};

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitSeparableConvolution(stream, VPI_BACKEND_CUDA, input, output, sobel_row, 7, sobel_col, 7, VPI_BORDER_ZERO);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_sepConv.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.9.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建卷积核

sobel_row = [-1, -5, -6, 0, +6, +5, +1];

sobel_col = [1 / 64.0, 6 / 64.0, 15 / 64.0, 20 / 64.0, 15 / 64.0, 6 / 64.0, 1 / 64.0]

# step4 执行操作

with vpi.Backend.CUDA:

output = input.convolution(kernel_x=sobel_row, kernel_y=sobel_col, border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_sepConv.jpg", outData)

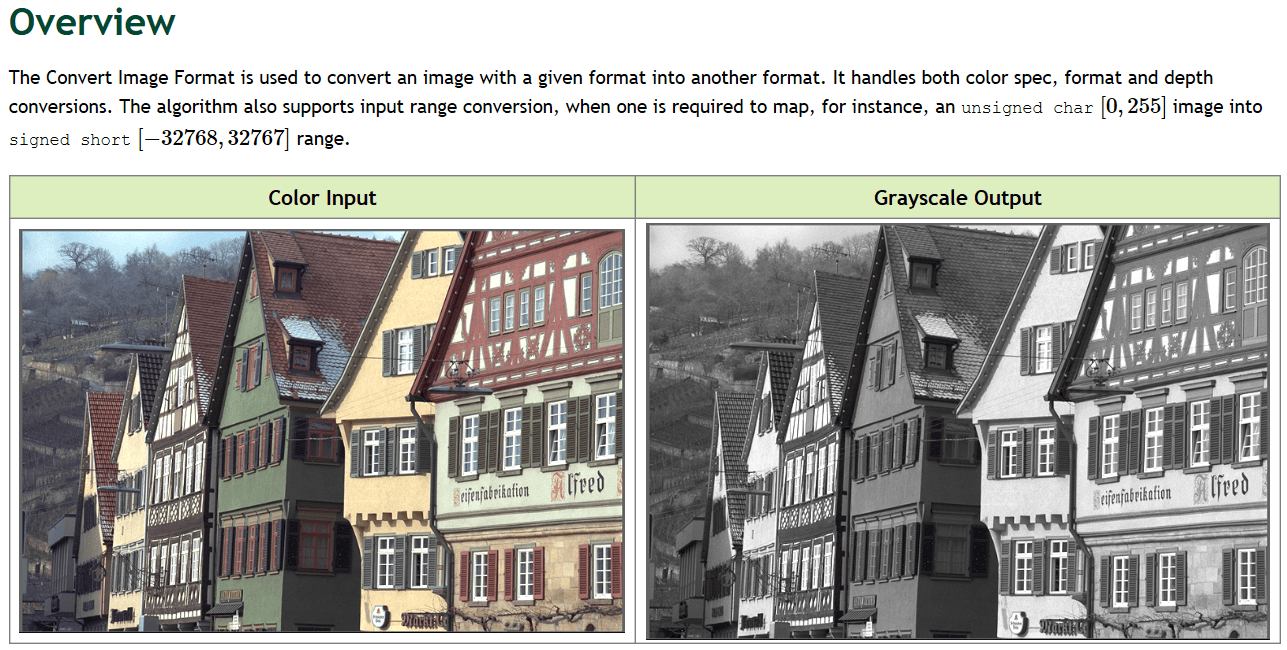

1.10 Convert Image Format

官方文档是这个。这个函数主要的作用是转换影像的格式。比如将一个无符号char类型(0-255)的影像转换为有符号short类型(-32768到32767)。此外,函数支持灰度到彩色、灰度到灰度、彩色到灰度的转换。效果如下。

C++需引用

C++需引用vpi/algo/ConvertImageFormat.h,名字为vpiSubmitConvertImageFormat(),Python需导入vpi包,名字为.convert()。

1.10.1 常见影像格式

完整格式和详细说明参考上面提到的官方文档。这里简单列举。对于彩色空间,常见格式有:

- YUV颜色空间

- 简化量化范围

- VPI_IMAGE_FORMAT_NV12 (Y:16-235, Cb&Cr:16-240(分辨率为luma plane的一半))

- VPI_IMAGE_FORMAT_NV12_BL (Y:16-235, Cb&Cr:0-255(分辨率为luma plane的一半))

- VPI_IMAGE_FORMAT_NV24 (Y:16-235, Cb&Cr:16-240(分辨率与luma plane相同))

- VPI_IMAGE_FORMAT_NV24_BL (Y:16-235, Cb&Cr:0-255(分辨率与luma plane相同))

- VPI_IMAGE_FORMAT_YUYV

- VPI_IMAGE_FORMAT_YUYV_BL

- VPI_IMAGE_FORMAT_UYVY

- VPI_IMAGE_FORMAT_UYVY_BL

- 扩展量化范围

- VPI_IMAGE_FORMAT_NV12_ER (Y:0-255, Cb&Cr:0-255(分辨率为luma plane的一半))

- VPI_IMAGE_FORMAT_NV12_ER_BL (Y:0-255, Cb&Cr:0-255(分辨率为luma plane的一半))

- VPI_IMAGE_FORMAT_NV24_ER (Y:0-255, Cb&Cr:0-255(分辨率与luma plane相同))

- VPI_IMAGE_FORMAT_NV24_ER_BL (Y:0-255, Cb&Cr:0-255(分辨率与luma plane相同))

- VPI_IMAGE_FORMAT_YUYV_ER

- VPI_IMAGE_FORMAT_YUYV_ER_BL

- VPI_IMAGE_FORMAT_UYVY_ER

- VPI_IMAGE_FORMAT_UYVY_ER_BL

- 简化量化范围

- RGB颜色空间

- 没有alpha透明通道

- VPI_IMAGE_FORMAT_RGB8

- VPI_IMAGE_FORMAT_BGR8

- 有alpha透明通道

- VPI_IMAGE_FORMAT_RGBA8

- VPI_IMAGE_FORMAT_BGRA8

- 没有alpha透明通道

对于单通道灰度影像,常见格式有:

- luma格式

- 简化量化范围

- VPI_IMAGE_FORMAT_Y8 (Y:16-235)

- VPI_IMAGE_FORMAT_Y8_BL (Y:16-235)

- 扩展量化范围

- VPI_IMAGE_FORMAT_Y8_ER (Y:0-255)

- VPI_IMAGE_FORMAT_Y8_ER_BL (Y:0-255)

- VPI_IMAGE_FORMAT_Y16_ER (Y:0-65535)

- VPI_IMAGE_FORMAT_Y16_ER_BL (Y:0-65535)

- 简化量化范围

- 灰度整型格式

- VPI_IMAGE_FORMAT_U8 (8-bit unsigned integer)

- VPI_IMAGE_FORMAT_S8 (8-bit signed integer)

- VPI_IMAGE_FORMAT_U16 (16-bit unsigned integer)

- VPI_IMAGE_FORMAT_S16 (16-bit signed integer)

- 灰度浮点型格式

- VPI_IMAGE_FORMAT_F32 (32-bit floating point)

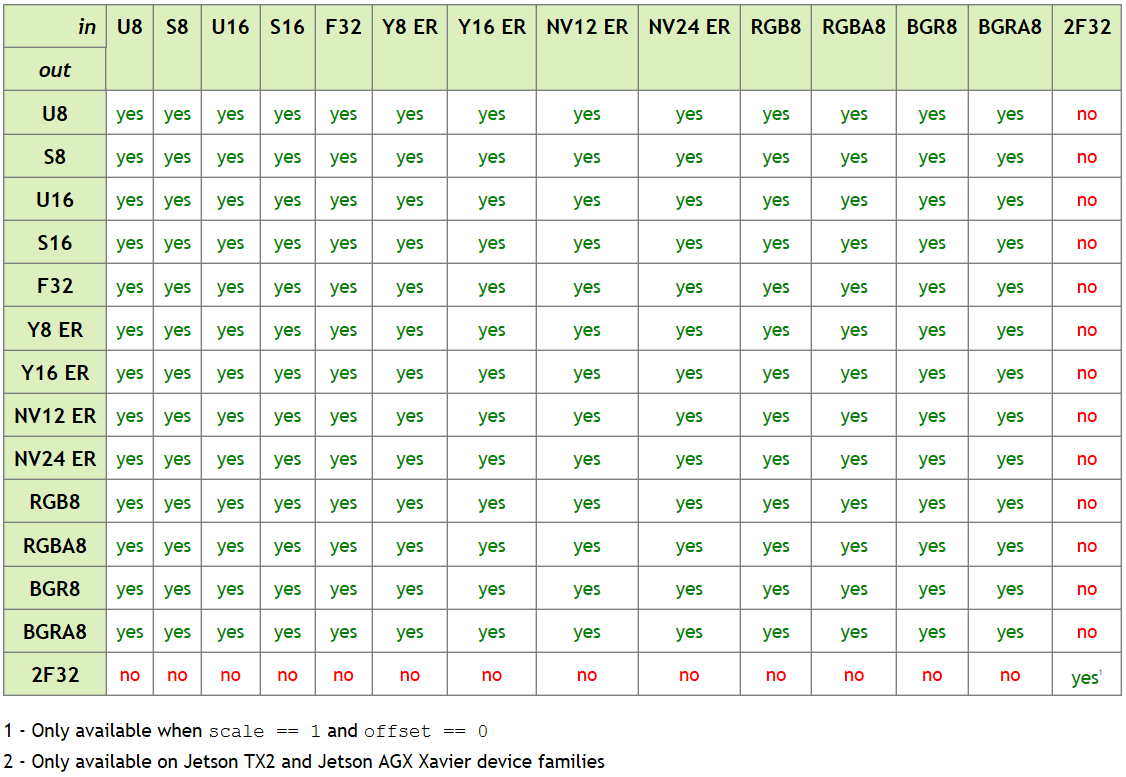

在CPU和CUDA后端上,可用的转换见下表。

更详细的转换pipeline见官方文档,此处不再赘述。

更详细的转换pipeline见官方文档,此处不再赘述。

1.10.2 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/ConvertImageFormat.h> // ConvertImageFormat头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_COLOR);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, VPI_IMAGE_FORMAT_U8, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// step7 创建转换相关参数

VPIConvertImageFormatParams cvtParams;

vpiInitConvertImageFormatParams(&cvtParams);

cvtParams.policy = VPI_CONVERSION_CLAMP;

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CPU, input, output, &cvtParams);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_cvt.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.10.3 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_COLOR)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.convert(vpi.Format.U8)

# step4 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_cvt.jpg", outData)

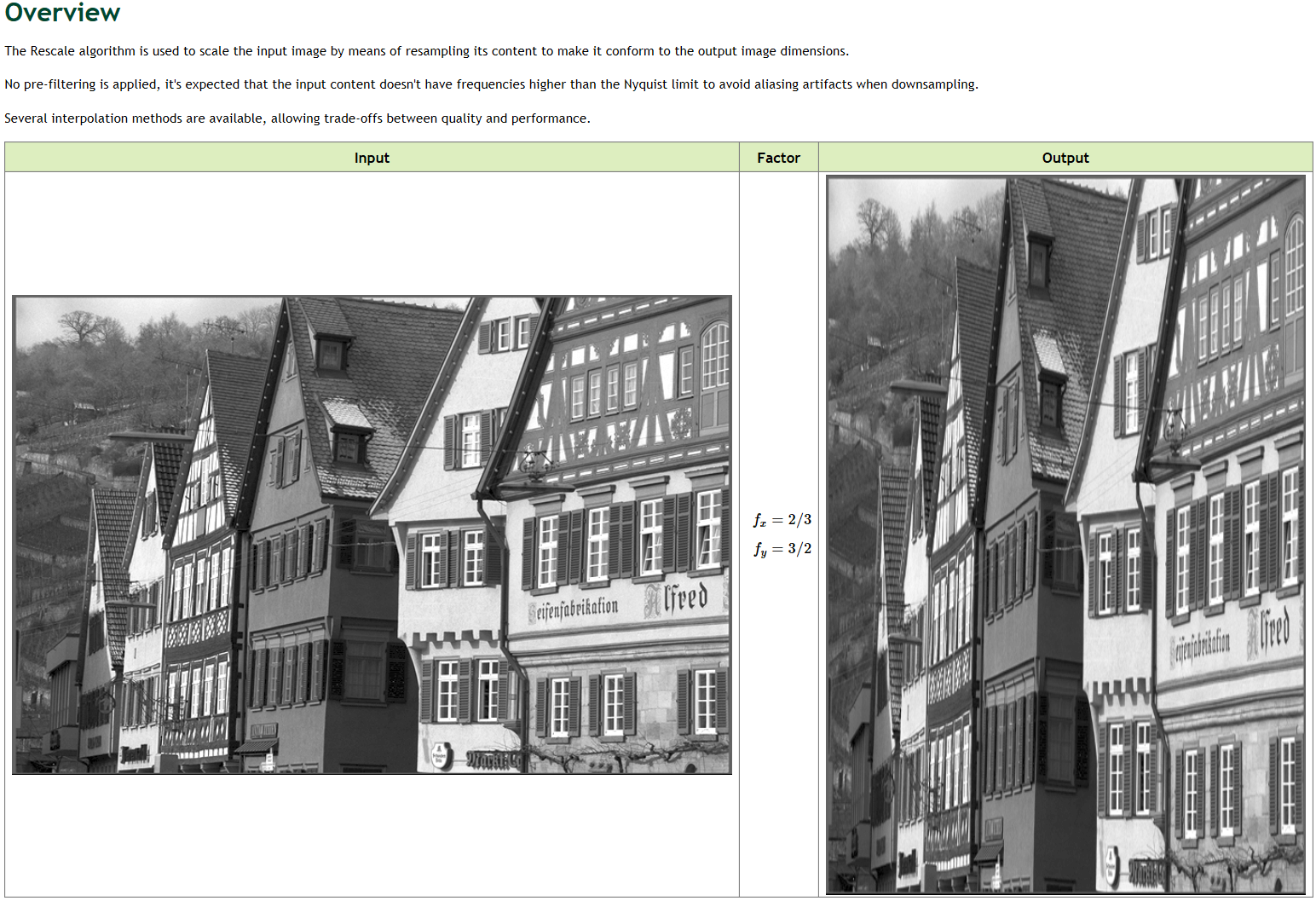

1.11 Rescale

官方文档是这个。实现对于影像的缩放。效果如下。

C++需引用

C++需引用vpi/algo/Rescale.h,名字为vpiSubmitRescale(),Python需导入vpi包,名字为.rescale()。

1.11.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/Rescale.h> // Rescale头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w * 2 / 3.0f, h * 3 / 2.0f, type, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step7 将操作提交到流中执行

vpiSubmitRescale(stream, VPI_BACKEND_CUDA, input, output, VPI_INTERP_LINEAR, VPI_BORDER_ZERO, 0);

// step8 等待所有操作执行完成

vpiStreamSync(stream);

// step9 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step10 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_rescale.jpg", out_mat);

// step11 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step12 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.11.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step4 执行操作

with vpi.Backend.CUDA:

output = input.rescale((input.width * 2 // 3, input.height * 3 // 2), interp=vpi.Interp.LINEAR,

border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_rescale.jpg", outData)

1.12 Remap

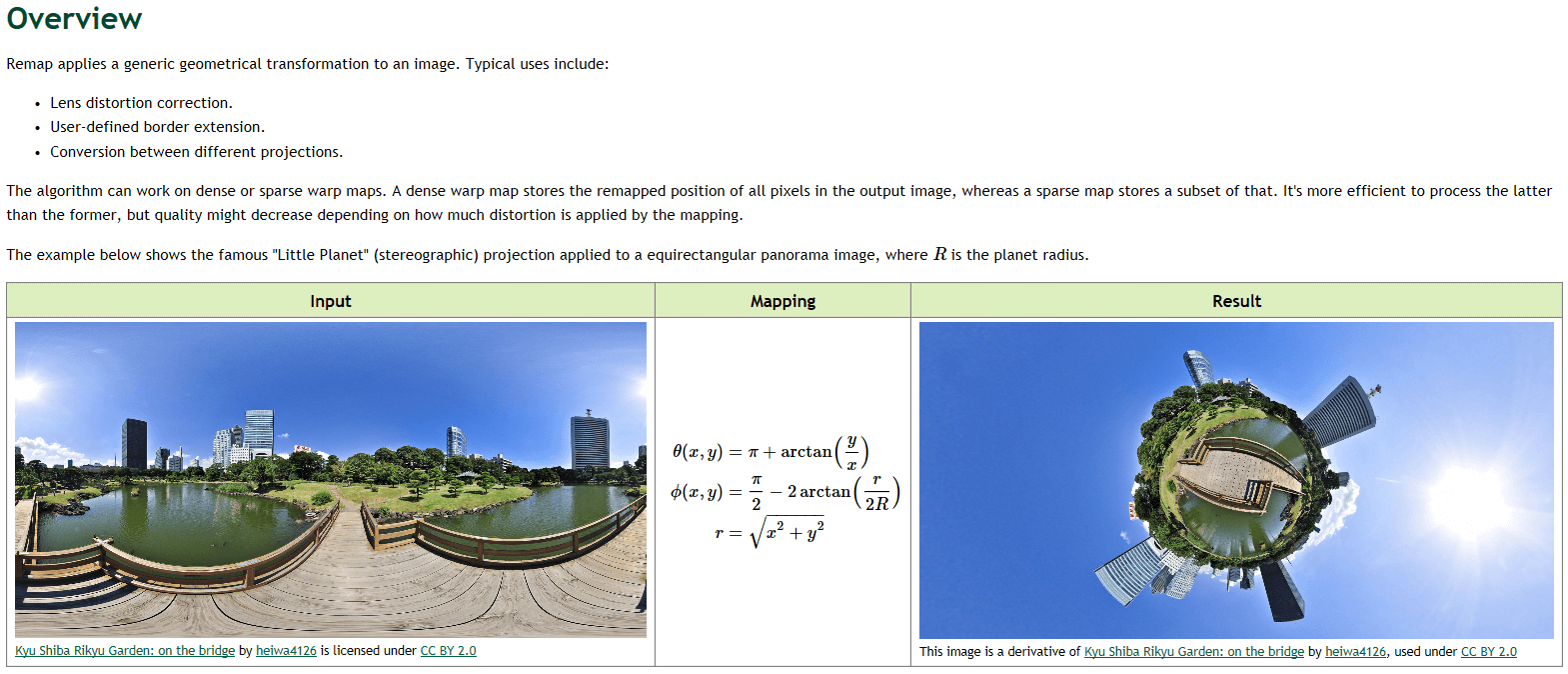

官方文档是这个。可以实现图像间的变换、镜头畸变校正等变换。效果如下。

C++需引用

C++需引用vpi/WarpMap.h和vpi/algo/Remap.h,名字为vpiCreateRemap()和vpiSubmitRemap(),Python需导入vpi包,名字为vpi.WarpMap()和.remap()。

1.12.1 实现原理

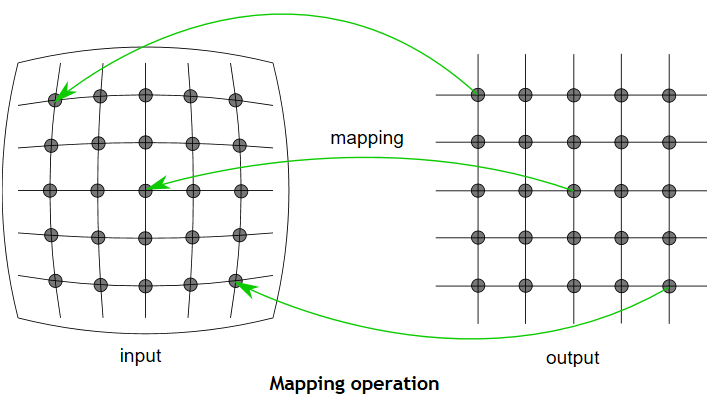

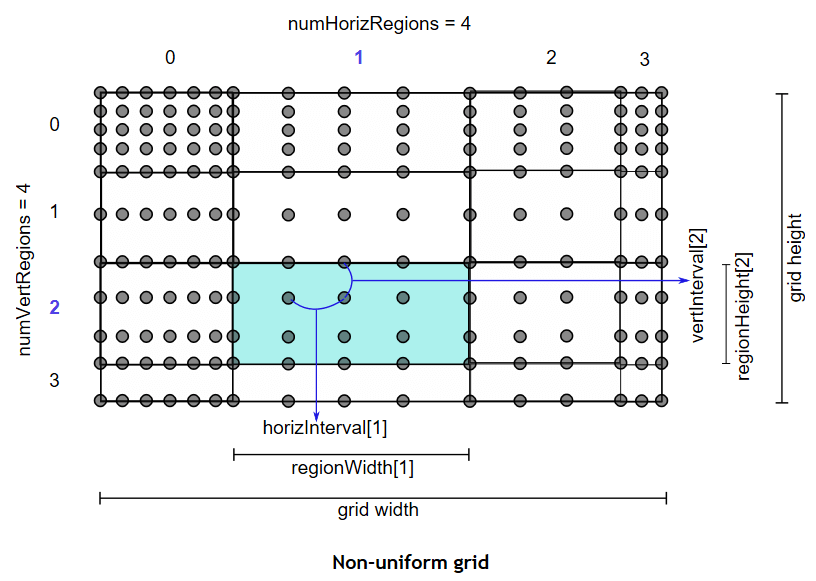

对于此类的变换,核心就是构建一个统一的变换关系,然后将原图中的像素一一解算到新的影像上即可。在VPI中,我们可以实现稠密、稀疏(等间隔)、稀疏(不等间隔)的变换,如下。

在VPI中,mapping可以分为两个步骤。首先是基于稀疏映射图通过双线性内插生成稠密图,第二步则是基于这个稠密图对原图中的像素进行采样。

在VPI中,mapping可以分为两个步骤。首先是基于稀疏映射图通过双线性内插生成稠密图,第二步则是基于这个稠密图对原图中的像素进行采样。

1.12.2 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/Remap.h> // Remap头文件

#include <vpi/WarpMap.h> // VPI WarpMap类头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

// step6 创建稠密的Warp Map

VPIWarpMap map;

memset(&map, 0, sizeof(map));

map.grid.numHorizRegions = 1;

map.grid.numVertRegions = 1;

map.grid.regionWidth[0] = w;

map.grid.regionHeight[0] = h;

map.grid.horizInterval[0] = 1;

map.grid.vertInterval[0] = 1;

vpiWarpMapAllocData(&map);

// step7 创建小星球特效

vpiWarpMapGenerateIdentity(&map);

int i;

for (i = 0; i < map.numVertPoints; ++i) {

VPIKeypointF32 *row = (VPIKeypointF32 *) ((uint8_t *) map.keypoints + map.pitchBytes * i);

int j;

for (j = 0; j < map.numHorizPoints; ++j) {

float x = row[j].x - w / 2.0f;

float y = row[j].y - h / 2.0f;

const float R = h / 8.0f; /* planet radius */

const float r = sqrtf(x * x + y * y);

float theta = M_PI + atan2f(y, x);

float phi = M_PI / 2 - 2 * atan2f(r, 2 * R);

row[j].x = fmod((theta + M_PI) / (2 * M_PI) * (w - 1), w - 1);

row[j].y = (phi + M_PI / 2) / M_PI * (h - 1);

}

}

// step8 创建算法需要的payload

VPIPayload warp;

vpiCreateRemap(VPI_BACKEND_CUDA, &map, &warp);

// step9 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step10 将操作提交到流中执行

vpiSubmitRemap(stream, VPI_BACKEND_CUDA, warp, input, output, VPI_INTERP_LINEAR, VPI_BORDER_ZERO, 0);

// step11 等待所有操作执行完成

vpiStreamSync(stream);

// step12 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step13 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_remap.jpg", out_mat);

// step14 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step15 销毁相关资源

vpiStreamDestroy(stream);

vpiPayloadDestroy(warp);

vpiWarpMapFreeData(&map);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.12.3 Python接口

import cv2

import numpy as np

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建warp map

warp = vpi.WarpMap(vpi.WarpGrid(input.size))

wx, wy = np.asarray(warp).transpose(2, 1, 0)

x = wx - input.width / 2

y = wy - input.height / 2

R = input.height / 8 # planet radius

r = np.sqrt(x * x + y * y)

theta = np.pi + np.arctan2(y, x)

phi = np.pi / 2 - 2 * np.arctan2(r, 2 * R)

wx[:] = np.fmod((theta + np.pi) / (2 * np.pi) * (input.width - 1), input.width - 1)

wy[:] = (phi + np.pi / 2) / np.pi * (input.height - 1)

# step4 执行操作

with vpi.Backend.CUDA:

output = input.remap(warp)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_remap.jpg", outData)

1.13 Perspective Warp

官方文档是这个。该函数可以实现投影变换。效果如下。

C++需引用

C++需引用vpi/algo/PerspectiveWarp.h,名字为vpiSubmitPerspectiveWarp(),Python需导入vpi包,名字为.perspwarp()。

1.13.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/PerspectiveWarp.h> // PerspectiveWarp头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(w, h, type, 0, &output);

// step6 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// step7 创建变换

const VPIPerspectiveTransform xform =

{

{0.5386, 0.1419, -74},

{-0.4399, 0.8662, 291.5},

{-0.0005, 0.0003, 1}

};

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 将操作提交到流中执行

vpiSubmitPerspectiveWarp(stream, VPI_BACKEND_CPU, input, xform, output, NULL, VPI_INTERP_LINEAR, VPI_BORDER_ZERO,

0);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据

VPIImageData outData;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &outData);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(outData, &out_mat);

imwrite("../test-data/out_persp.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.13.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "./test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 创建变换

xform = [[0.5386, 0.1419, -74],

[-0.4399, 0.8662, 291.5],

[-0.0005, 0.0003, 1]]

# step4 执行操作

with vpi.Backend.CUDA:

output = input.perspwarp(xform)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("./test-data/out_persp.jpg", outData)

1.14 FFT

官方文档是这个。经典傅立叶变换。VPI的实现细节可以看上面的这个文档,此处不再赘述。效果如下。

C++需引用

C++需引用vpi/algo/FFT.h,名字为vpiCreateFFT()和vpiSubmitFFT(),Python需导入vpi包,名字为.fft()。

1.14.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/ConvertImageFormat.h> // ConvertImageFormat头文件

#include <vpi/algo/FFT.h> // FFT头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t width, height;

vpiImageGetSize(input, &width, &height);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建Float32类型的输入影像

VPIImage inputF32;

vpiImageCreate(width, height, VPI_IMAGE_FORMAT_F32, 0, &inputF32);

// step6 创建用于可视化的谱段的影像

float *tmpBuffer = (float *) malloc(width * 2 * height * sizeof(float));

// step7 创建输出谱段影像

VPIImage spectrum;

vpiImageCreate(width / 2 + 1, height, VPI_IMAGE_FORMAT_2F32, 0, &spectrum);

// step8 创建FFT对应Payload

VPIPayload fft;

vpiCreateFFT(VPI_BACKEND_CUDA, width, height, VPI_IMAGE_FORMAT_F32, VPI_IMAGE_FORMAT_2F32, &fft);

// step9 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step10 将输入的Uint8类型影像转化为Float32类型

vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, input, inputF32, NULL);

// step11 执行傅立叶变换

vpiSubmitFFT(stream, VPI_BACKEND_CUDA, fft, inputF32, spectrum, 0);

// step12 等待所有操作执行完成

vpiStreamSync(stream);

// step13 创建锁定对象,取出数据到tmpBuffer

VPIImageData data;

vpiImageLockData(spectrum, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data);

// step13.1 可视化谱段处理

// Fills the right half of the complex data with the missing values. The left half is copied directly from VPI's output.

/* make width/height even*/

width = width & -2;

height = height & -2;

/* center pixel coordinate */

int cx = width / 2;

int cy = height / 2;

/* Image data is in host-accessible pitch-linear layout. */

assert(data.bufferType == VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR);

VPIImageBufferPitchLinear *dataPitch = &data.buffer.pitch;

int i, j;

for (i = 0; i < (int) height; ++i) {

for (j = 0; j < (int) width; ++j) {

float re, im;

if (j < cx) {

const float *pix =

(const float *) ((const char *) dataPitch->planes[0].data +

i * dataPitch->planes[0].pitchBytes) +

j * 2;

re = pix[0];

im = pix[1];

} else {

const float *pix = (const float *) ((const char *) dataPitch->planes[0].data +

((height - i) % height) * dataPitch->planes[0].pitchBytes) +

((width - j) % width) * 2;

/* complex conjugate */

re = pix[0];

im = -pix[1];

}

tmpBuffer[i * (width * 2) + j * 2] = re;

tmpBuffer[i * (width * 2) + j * 2 + 1] = im;

}

}

// step13.2 Convert the complex frequencies into normalized log-magnitude

float min = FLT_MAX, max = -FLT_MAX;

for (i = 0; i < (int) height; ++i) {

for (j = 0; j < (int) width; ++j) {

float re, im;

re = tmpBuffer[i * (width * 2) + j * 2];

im = tmpBuffer[i * (width * 2) + j * 2 + 1];

float mag = logf(sqrtf(re * re + im * im) + 1);

tmpBuffer[i * width + j] = mag;

min = mag < min ? mag : min;

max = mag > max ? mag : max;

}

}

for (i = 0; i < (int) height; ++i) {

for (j = 0; j < (int) width; ++j) {

tmpBuffer[i * width + j] = (tmpBuffer[i * width + j] - min) / (max - min);

}

}

// step13.3 Shift the spectrum so that DC is at center

for (i = 0; i < (int) height; ++i) {

for (j = 0; j < (int) cx; ++j) {

float a = tmpBuffer[i * width + j];

/* quadrant 0? */

if (i < cy) {

/* swap it with quadrant 3 */

tmpBuffer[i * width + j] = tmpBuffer[(i + cy) * width + (j + cx)];

tmpBuffer[(i + cy) * width + (j + cx)] = a;

}

/* quadrant 2? */

else {

/* swap it with quadrant 1*/

tmpBuffer[i * width + j] = tmpBuffer[(i - cy) * width + (j + cx)];

tmpBuffer[(i - cy) * width + (j + cx)] = a;

}

}

}

// step14 将取出的数据转换为OpenCV格式并保存

// tmpBuffer波动范围在0到1之间

Mat out_mat(height, width, CV_32F, tmpBuffer);

out_mat = out_mat * 255;

imwrite("../test-data/out_fft.jpg", out_mat);

// step15 解除对对象的锁定

vpiImageUnlock(spectrum);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step16 销毁相关资源

vpiStreamDestroy(stream);

vpiImageDestroy(input);

vpiImageDestroy(inputF32);

vpiImageDestroy(spectrum);

free(tmpBuffer);

// -------------------------------------------------------------------

return 0;

}

1.14.2 Python接口

import cv2

import vpi # 导入VPI包

import numpy as np

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step4 执行操作

with vpi.Backend.CUDA:

output = input.convert(vpi.Format.F32).fft()

# step5 变换后的后处理,以方便可视化

hfreq = output.cpu().view(dtype=np.complex64).squeeze(2)

if input.width % 2 == 0:

wpad = input.width // 2 - 1

padmode = 'reflect'

else:

wpad = input.width // 2

padmode = 'symmetric'

freq = np.pad(hfreq, ((0, 0), (0, wpad)), mode=padmode)

freq[:, hfreq.shape[1]:] = np.conj(freq[:, hfreq.shape[1]:])

freq[1:, hfreq.shape[1]:] = freq[1:, hfreq.shape[1]:][::-1]

lmag = np.log(1 + np.absolute(freq))

spectrum = np.fft.fftshift(lmag)

# step6 结果输出

max_v = np.max(spectrum)

min_v = np.min(spectrum)

scale = 255 / (max_v - min_v)

spectrum = scale * (spectrum - min_v)

cv2.imwrite("../test-data/out_fft.jpg", spectrum)

1.15 Inverse FFT

官方文档是这个。用于实现经典逆傅立叶变换。效果如下。

C++需引用

C++需引用vpi/algo/FFT.h,名字为vpiCreateIFFT()和vpiSubmitIFFT(),Python需导入vpi包,名字为.irfft()。

1.15.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/FFT.h> // IFFT头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/out_fft.jpg";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

Mat img_norm;

img.convertTo(img_norm, CV_32FC2);

img_norm = img_norm / 255;

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img_norm, 0, &input);

// step3 获取影像大小

int32_t width, height;

vpiImageGetSize(input, &width, &height);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(width, height, VPI_IMAGE_FORMAT_F32, 0, &output);

// step6 创建IFFT对应Payload

VPIPayload ifft;

vpiCreateIFFT(VPI_BACKEND_CUDA, width, height, VPI_IMAGE_FORMAT_2F32, VPI_IMAGE_FORMAT_2F32, &ifft);

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step8 执行操作

vpiSubmitIFFT(stream, VPI_BACKEND_CUDA, ifft, input, output, 0);

// step9 等待所有操作执行完成

vpiStreamSync(stream);

// step10 创建锁定对象,取出数据到tmpBuffer

VPIImageData data;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data);

// step11 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(data, &out_mat);

imwrite("../test-data/out_ifft.jpg", out_mat);

// step12 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiPayloadDestroy(ifft);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.15.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/out_ifft.jpg"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 执行操作

with vpi.Backend.CUDA:

output = input.irfft()

1.16 Lens Distortion Correction

官方文档是这个。主要用于镜头的畸变矫正。目前在VPI中主要支持两类畸变:多项式畸变(Polynomial)和鱼眼畸变(Fisheye)。实现细节见上面的文档。效果如下。

C++需引用

C++需引用vpi/algo/LensDistortionModels.h和vpi/algo/Remap.h,名字为vpiWarpMapGenerateFromFisheyeLensDistortionModel()和vpiWarpMapGenerateFromPolynomialLensDistortionModel(),Python需导入vpi包,名字为.fisheye_correction()。

1.16.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/LensDistortionModels.h> // DistortionModel头文件

#include <vpi/algo/Remap.h> // Remap头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img, 0, &input);

// step3 获取影像大小

int32_t width, height;

vpiImageGetSize(input, &width, &height);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出影像

VPIImage output;

vpiImageCreate(width, height, type, 0, &output);

// step6 构造校正变换关系

VPIWarpMap map;

memset(&map, 0, sizeof(map));

map.grid.numHorizRegions = 1;

map.grid.numVertRegions = 1;

map.grid.regionWidth[0] = width;

map.grid.regionHeight[0] = height;

map.grid.horizInterval[0] = 1;

map.grid.vertInterval[0] = 1;

vpiWarpMapAllocData(&map);

// step7 构造校正模型

VPIFisheyeLensDistortionModel fisheye;

memset(&fisheye, 0, sizeof(fisheye));

fisheye.mapping = VPI_FISHEYE_EQUIDISTANT;

fisheye.k1 = -0.126;

fisheye.k2 = 0.004;

fisheye.k3 = 0;

fisheye.k4 = 0;

float sensorWidth = 22.2; /* APS-C sensor */

float focalLength = 7.5;

float f = focalLength * width / sensorWidth;

const VPICameraIntrinsic K =

{

{f, 0, static_cast<float>(width / 2.0)},

{0, f, static_cast<float>(height / 2.0)}

};

const VPICameraExtrinsic X =

{

{1, 0, 0, 0},

{0, 1, 0, 0},

{0, 0, 1, 0}

};

vpiWarpMapGenerateFromFisheyeLensDistortionModel(K, X, K, &fisheye, &map);

// step8 创建校正对应Payload

VPIPayload warp;

vpiCreateRemap(VPI_BACKEND_CUDA, &map, &warp);

// step9 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step10 执行操作

vpiSubmitRemap(stream, VPI_BACKEND_CUDA, warp, input, output, VPI_INTERP_CATMULL_ROM, VPI_BORDER_ZERO, 0);

// step11 等待所有操作执行完成

vpiStreamSync(stream);

// step12 创建锁定对象,取出数据到tmpBuffer

VPIImageData data;

vpiImageLockData(output, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data);

// step13 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(data, &out_mat);

imwrite("../test-data/out_dist.jpg", out_mat);

// step14 解除对对象的锁定

vpiImageUnlock(output);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step15 销毁相关资源

vpiStreamDestroy(stream);

vpiPayloadDestroy(warp);

vpiWarpMapFreeData(&map);

vpiImageDestroy(input);

vpiImageDestroy(output);

// -------------------------------------------------------------------

return 0;

}

1.16.2 Python接口

import cv2

import vpi # 导入VPI包

import numpy as np

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img)

# step3 构造变换关系

grid = vpi.WarpGrid(input.size)

sensorWidth = 22.2 # APS-C sensor

focalLength = 7.5

f = focalLength * input.width / sensorWidth

K = [[f, 0, input.width / 2],

[0, f, input.height / 2]]

X = np.eye(3, 4)

warp = vpi.WarpMap.fisheye_correction(grid, K=K, X=X,

mapping=vpi.FisheyeMapping.EQUIDISTANT,

coeffs=[-0.126, 0.004])

# step4 执行操作

with vpi.Backend.CUDA:

output = input.remap(warp, interp=vpi.Interp.CATMULL_ROM, border=vpi.Border.ZERO)

# step5 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_dist.jpg", outData)

1.17 Stereo Disparity Estimator

官方文档是这个。可以实现双目视差图估计。效果如下。

C++需引用

C++需引用vpi/algo/StereoDisparity.h,名字为vpiCreateStereoDisparityEstimator(),Python需导入vpi包,名字为vpi.stereodisp()。

1.17.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/StereoDisparity.h> // StereoDisparity头文件

#include <vpi/algo/ConvertImageFormat.h> // 影像类型转换头文件

using namespace cv;

using namespace std;

int main() {

string img_path1 = "../test-data/chair_stereo_left_grayscale.png";

string img_path2 = "../test-data/chair_stereo_right_grayscale.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img1 = imread(img_path1, IMREAD_GRAYSCALE);

Mat img2 = imread(img_path2, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage left, right;

vpiImageCreateWrapperOpenCVMat(img1, 0, &left);

vpiImageCreateWrapperOpenCVMat(img2, 0, &right);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(left, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(left, &type);

// step5 创建输出影像

VPIImage disparity;

vpiImageCreate(w, h, VPI_IMAGE_FORMAT_S16, 0, &disparity);

VPIImage confidence;

vpiImageCreate(w, h, VPI_IMAGE_FORMAT_U16, 0, &confidence);

VPIImage display;

vpiImageCreate(w, h, VPI_IMAGE_FORMAT_U8, 0, &display);

// step6 视差估计参数

VPIStereoDisparityEstimatorParams params;

vpiInitStereoDisparityEstimatorParams(¶ms);

params.windowSize = 5;

params.maxDisparity = 64;

// step7 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// step8 创建对应Payload

VPIPayload stereo;

vpiCreateStereoDisparityEstimator(VPI_BACKEND_CUDA, 480, 270, VPI_IMAGE_FORMAT_U16, NULL, &stereo);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step9 执行操作

vpiSubmitStereoDisparityEstimator(stream, VPI_BACKEND_CUDA, stereo, left, right, disparity, confidence, ¶ms);

VPIConvertImageFormatParams cvtParams;

vpiInitConvertImageFormatParams(&cvtParams);

cvtParams.scale = 1.0f / (32 * params.maxDisparity) * 255;

vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, disparity, display, &cvtParams);

// step10 等待所有操作执行完成

vpiStreamSync(stream);

// step11 创建锁定对象,取出数据

VPIImageData data;

vpiImageLockData(display, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data);

// step12 将取出的数据转换为OpenCV格式并保存

Mat out_mat;

vpiImageDataExportOpenCVMat(data, &out_mat);

imwrite("../test-data/out_disparity.jpg", out_mat);

// step13 解除对对象的锁定

vpiImageUnlock(display);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step14 销毁相关资源

vpiStreamDestroy(stream);

vpiPayloadDestroy(stereo);

vpiImageDestroy(left);

vpiImageDestroy(right);

vpiImageDestroy(display);

vpiImageDestroy(disparity);

vpiImageDestroy(confidence);

// -------------------------------------------------------------------

return 0;

}

1.17.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path1 = "../test-data/chair_stereo_left_grayscale.png"

img_path2 = "../test-data/chair_stereo_right_grayscale.png"

# step1 利用OpenCV读取影像

img1 = cv2.imread(img_path1, cv2.IMREAD_GRAYSCALE)

img2 = cv2.imread(img_path2, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

left = vpi.asimage(img1)

right = vpi.asimage(img2)

# step3 执行操作

with vpi.Backend.CUDA:

output = vpi.stereodisp(left, right, window=5, maxdisp=64) \

.convert(vpi.Format.U8, scale=1.0 / (32 * 64) * 255)

# step4 结果输出

with output.rlock_cpu() as outData:

cv2.imwrite("../test-data/out_disparity.jpg", outData)

1.18 KLT Feature Tracker

官方文档是这个。用于实现KLT特征光流跟踪。效果如下。

C++需引用

C++需引用vpi/algo/KLTFeatureTracker.h,名字为vpiSubmitKLTFeatureTracker(),Python需导入vpi包,名字为vpi.KLTFeatureTracker()。

1.18.1 C++接口

#include <vpi/algo/KLTFeatureTracker.h>

int frame_count = /*... */;

VPIImage *frames = /* ... */;

int bbox_count = /* ... */;

VPIBoundingBox *bboxes = /* ... */;

VPIKLTTrackedBoundingBox tracked_bboxes[128];

int b;

for (b = 0; b < bbox_count; ++b)

{

tracked_bboxes[b].bbox = bboxes[b];

tracked_bboxes[b].trackingStatus = 0; /* valid tracking */

tracked_bboxes[b].templateStatus = 1; /* must update */

}

VPIArrayData data_bboxes;

memset(&data_bboxes, 0, sizeof(data_bboxes));

data_bboxes.bufferType = VPI_ARRAY_BUFFER_HOST_AOS;

data_bboxes.buffer.aos.type = VPI_ARRAY_TYPE_KLT_TRACKED_BOUNDING_BOX;

data_bboxes.buffer.aos.capacity = 128;

data_bboxes.buffer.aos.sizePointer = &bbox_count;

data_bboxes.buffer.aos.data = tracked_bboxes;

VPIArray inputBoxList;

vpiArrayCreateWrapper(&data_bboxes, 0, &inputBoxList);

VPIHomographyTransform2D preds[128];

int i;

for (i = 0; i < bbox_count; ++i)

{

VPIHomographyTransform2D *xform = preds + i;

/* Identity transform. */

memset(xform, 0, sizeof(*xform));

xform->mat3[0][0] = 1;

xform->mat3[1][1] = 1;

xform->mat3[2][2] = 1;

}

VPIArrayData data_preds;

memset(&data_preds, 0, sizeof(data_preds));

data_preds.bufferType = VPI_ARRAY_BUFFER_HOST_AOS;

data_preds.buffer.aos.type = VPI_ARRAY_TYPE_HOMOGRAPHY_TRANSFORM_2D;

data_preds.buffer.aos.capacity = 128;

int32_t data_preds_size = bbox_count;

data_preds.buffer.aos.sizePointer = &data_preds_size;

data_preds.buffer.aos.data = preds;

VPIArray inputPredList;

vpiArrayCreateWrapper(&data_preds, 0, &inputPredList);

VPIImageFormat imgFormat;

vpiImageGetFormat(frames[0], &imgFormat);

int width, height;

vpiImageGetSize(frames[0], &width, &height);

VPIPayload klt;

vpiCreateKLTFeatureTracker(VPI_BACKEND_CUDA, width, height, imgFormat, NULL, &klt);

VPIKLTFeatureTrackerParams params;

vpiInitKLTFeatureTrackerParams(¶ms);

VPIArray outputBoxList;

vpiArrayCreate(128, VPI_ARRAY_TYPE_KLT_TRACKED_BOUNDING_BOX, 0, &outputBoxList);

VPIArray outputEstimList;

vpiArrayCreate(128, VPI_ARRAY_TYPE_HOMOGRAPHY_TRANSFORM_2D, 0, &outputEstimList);

VPIStream stream;

vpiStreamCreate(0, &stream);

for (int idframe = 1; idframe < frame_count; ++idframe)

{

VPIImage imgTemplate = frames[idframe - 1];

VPIImage imgReference = frames[idframe];

VPI_CHECK_STATUS(vpiSubmitKLTFeatureTracker(stream, VPI_BACKEND_CUDA, klt, imgTemplate, inputBoxList,

inputPredList, imgReference, outputBoxList, outputEstimList,

¶ms));

vpiStreamSync(stream);

VPIArrayData updatedBBoxData;

vpiArrayLockData(outputBoxList, VPI_LOCK_READ, VPI_ARRAY_BUFFER_HOST_AOS, &updatedBBoxData);

VPIArrayData estimData;

vpiArrayLockData(outputEstimList, VPI_LOCK_READ, VPI_ARRAY_BUFFER_HOST_AOS, &estimData);

VPIKLTTrackedBoundingBox *updated_bbox = (VPIKLTTrackedBoundingBox *)updatedBBoxData.buffer.aos.data;

VPIHomographyTransform2D *estim = (VPIHomographyTransform2D *)estimData.buffer.aos.data;

vpiArrayLock(inputBoxList, VPI_LOCK_READ_WRITE);

vpiArrayLock(inputPredList, VPI_LOCK_READ_WRITE);

int b;

for (b = 0; b < bbox_count; ++b)

{

tracked_bboxes[b].trackingStatus = updated_bbox[b].trackingStatus;

tracked_bboxes[b].templateStatus = updated_bbox[b].templateStatus;

if (updated_bbox[b].trackingStatus)

{

continue;

}

if (updated_bbox[b].templateStatus)

{

tracked_bboxes[b] = updated_bbox[b];

memset(&preds[b], 0, sizeof(preds[b]));

preds[b].mat3[0][0] = 1;

preds[b].mat3[1][1] = 1;

preds[b].mat3[2][2] = 1;

}

else

{

preds[b] = estim[b];

}

}

vpiArrayUnlock(inputBoxList);

vpiArrayUnlock(inputPredList);

vpiArrayUnlock(outputBoxList);

vpiArrayUnlock(outputEstimList);

}

vpiStreamDestroy(stream);

vpiPayloadDestroy(klt);

vpiArrayDestroy(inputBoxList);

vpiArrayDestroy(inputPredList);

vpiArrayDestroy(outputBoxList);

vpiArrayDestroy(outputEstimList);

1.18.2 Python接口

import vpi

# This function reads the results of the KLT tracker (output bounding boxes and estimations) and updates the input bounding boxes and predictions for the next iteration.

def customUpdate(inBoxes, inPreds, outBoxes, outEstim):

with inBoxes.lock_cpu() as inBoxes_cpu, inPreds.lock_cpu() as inPreds_cpu, \

outBoxes.rlock_cpu() as outBoxes_cpu, outEstim.rlock_cpu() as outEstim_cpu:

inBoxes_ = inBoxes_cpu.view(np.recarray)

inPreds_ = inPreds_cpu.view(np.recarray)

outBoxes_ = outBoxes_cpu.view(np.recarray)

outEstim_ = outEstim_cpu.view(np.recarray)

for i in range(outBoxes.size):

# If the track status of a bounding box is lost, it assigns lost to the corresponding input bouding box.

if outBoxes_[i].tracking_status == vpi.KLTTrackStatus.LOST:

inBoxes_[i].tracking_status = vpi.KLTTrackStatus.LOST

continue

# If the template status is update needed, it updates the input bounding box with the corresponding output, making its prediction the identity matrix (fixing the bounding box).

if outBoxes_[i].template_status == vpi.KLTTemplateStatus.UPDATE_NEEDED:

inBoxes_[i] = outBoxes_[i]

inPreds_[i] = np.eye(3)

else:

# If the update is not needed, just update the input prediction by the corresponding output estimation.

inBoxes_[i].template_status = vpi.KLTTemplateStatus.UPDATE_NOT_NEEDED

inPreds_[i] = outEstim_[i]

def convertFrameImage(inputFrame):

if inputFrame.ndim == 3 and inputFrame.shape[2] == 3:

grayFrame = cv2.cvtColor(inputFrame, cv2.COLOR_BGR2GRAY)

else:

grayFrame = inputFrame

grayImage = vpi.asimage(grayFrame.copy())

return grayFrame, grayImage

inBoxes = vpi.Array(totalNumBoxes, vpi.Type.KLT_TRACKED_BOUNDING_BOX)

validFrame, cvFrame = inVideo.read()

if not validFrame:

print("Error reading first input frame", file=sys.stderr)

exit(1)

# Convert OpenCV frame to gray returning also the VPI image

cvGray, imgTemplate = convertFrameImage(cvFrame)

klt = vpi.KLTFeatureTracker(imgTemplate, inBoxes, backend=vpi.Backend.CUDA)

inPreds = klt.in_predictions()

while validFrame:

if curFrame in allBoxes:

klt.add_boxes(allBoxes[curFrame])

curFrame += 1

validFrame, cvFrame = inVideo.read()

if not validFrame:

break

cvGray, imgReference = convertFrameImage(cvFrame)

outBoxes = klt(imgReference, update=customUpdate)

1.19 Harris Corner Detector

官方文档是这个。用于实现Harris角点的提取。效果如下。

C++需引用

C++需引用vpi/algo/HarrisCorners.h,名字为vpiSubmitHarrisCornerDetector(),Python需导入vpi包,名字为vpi.harriscorners()。

1.19.1 C++接口

#include <iostream> // C++标准头文件

#include <opencv2/opencv.hpp> // OpenCV头文件

#include <opencv2/imgcodecs.hpp>

#include <vpi/OpenCVInterop.hpp> // VPI与OpenCV互操作的头文件

#include <vpi/Image.h> // VPI Image类头文件

#include <vpi/Stream.h> // VPI Stream类头文件

#include <vpi/algo/HarrisCorners.h> // HarrisCorners头文件

#include <vpi/Array.h> // VPI Array类头文件

using namespace cv;

using namespace std;

int main() {

string img_path = "../test-data/img1.png";

// 第一阶段:初始化

// -------------------------------------------------------------------

// step1 利用OpenCV读取影像

Mat img1 = imread(img_path, IMREAD_GRAYSCALE);

// step2 基于读取的影像构造VPIImage对象

VPIImage input;

vpiImageCreateWrapperOpenCVMat(img1, 0, &input);

// step3 获取影像大小

int32_t w, h;

vpiImageGetSize(input, &w, &h);

// step4 获取影像格式

VPIImageFormat type;

vpiImageGetFormat(input, &type);

// step5 创建输出keypoint

VPIArray keypoints;

vpiArrayCreate(8192, VPI_ARRAY_TYPE_KEYPOINT_F32, 0, &keypoints);

VPIArray scores;

vpiArrayCreate(8192, VPI_ARRAY_TYPE_U32, 0, &scores);

// step6 创建对应Payload

VPIPayload harris;

vpiCreateHarrisCornerDetector(VPI_BACKEND_CUDA, w, h, &harris);

// step7 创建Harris参数

VPIHarrisCornerDetectorParams params;

vpiInitHarrisCornerDetectorParams(¶ms);

params.sensitivity = 0.01;

// step8 创建执行流

VPIStream stream;

vpiStreamCreate(0, &stream);

// -------------------------------------------------------------------

// 第二阶段:处理并保存结果

// -------------------------------------------------------------------

// step9 执行操作

vpiSubmitHarrisCornerDetector(stream, 0, harris, input, keypoints, scores, ¶ms);

// step10 等待所有操作执行完成

vpiStreamSync(stream);

// step11 创建锁定对象,取出数据

VPIArrayData data;

vpiArrayLockData(keypoints,VPI_LOCK_READ, VPI_ARRAY_BUFFER_HOST_AOS, &data);

// step12 解除对对象的锁定

vpiArrayUnlock(keypoints);

// -------------------------------------------------------------------

// 第三阶段:清理资源

// -------------------------------------------------------------------

// step13 销毁相关资源

vpiStreamDestroy(stream);

vpiPayloadDestroy(harris);

vpiImageDestroy(input);

vpiArrayDestroy(keypoints);

vpiArrayDestroy(scores);

// -------------------------------------------------------------------

return 0;

}

1.19.2 Python接口

import cv2

import vpi # 导入VPI包

if __name__ == '__main__':

img_path = "../test-data/img1.png"

# step1 利用OpenCV读取影像

img1 = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)

# step2 将读取的Numpy Array对象转换成VPI的影像格式

input = vpi.asimage(img1)

# step3 执行操作

with vpi.Backend.CUDA:

keypoints, scores = input.harriscorners(sensitivity=0.01)

# step4 结果输出

with keypoints.rlock_cpu() as keyPointData:

print(keyPointData)

with scores.rlock_cpu() as scoreData:

print(scoreData)

1.20 Temporal Noise Reduction

官方文档是这个。用于实现时序噪声的去除。根据文档描述,VPI的这个函数更适合于热噪声(高斯分布)和拍摄噪声(泊松分布),对于其它类型的噪声效果可能不是很明显。效果如下。

C++需引用

C++需引用vpi/algo/TemporalNoiseReduction.h,名字为vpiSubmitTemporalNoiseReduction(),Python需导入vpi包,名字为vpi.TemporalNoiseReduction()。

在VPI中,提供了三个版本的函数,分别适用于不同的需求:

- VPI_TNR_V1:Offers basic noise reduction that works well when noise levels aren’t too high. Lighting conditions and noise reduction strength are fixed and can’t be configured, but in general it provides good speed.

- VPI_TNR_V2:Offers improved noise reduction, and can be configured for a particular lighting condition. Still provides good speed.

- VPI_TNR_V3:Offers best noise reduction quality and configurability, in exchange of some performance decrease.

1.20.1 C++接口

#include <vpi/algo/TemporalNoiseReduction.h>

VPIImage input;

vpiImageCreate(width, height, VPI_IMAGE_FORMAT_NV12_ER, 0, &input);

VPIImage prevOutput, output;

vpiImageCreate(width, height, VPI_IMAGE_FORMAT_NV12_ER, 0, &prevOutput);

vpiImageCreate(width, height, VPI_IMAGE_FORMAT_NV12_ER, 0, &output);

VPIPayload tnr;

vpiCreateTemporalNoiseReduction(VPI_BACKEND_CUDA, width, height, VPI_IMAGE_FORMAT_NV12_ER, VPI_TNR_DEFAULT, &tnr);

VPIStream stream;

vpiStreamCreate(0, &stream);

while (FetchFrame(vid, &input))

{

VPITNRParams params;

vpiInitTemporalNoiseReductionParams(¶ms);

params.preset = VPI_TNR_PRESET_OUTDOOR_MEDIUM_LIGHT;

params.strength = 1.0f;

if (isFirstFrame)

{

vpiSubmitTemporalNoiseReduction(stream, VPI_BACKEND_CUDA, tnr, NULL, input, output, ¶ms);

}

else

{